안녕하세요,

AI 기술이 빠르게 발전하면서, 누구나 쉽게 활용할 수 있는 고성능 AI 모델에 대한 관심이 높아지고 있습니다. 특히, 강력한 성능을 유지하면서도 가볍고 효율적으로 실행할 수 있는 모델은 많은 사용자들에게 매력적인 선택지가 되고 있습니다.

이번 글에서 소개해드릴 AI 모델은 바로 QwQ-32B입니다. QwQ-32B는 강화 학습을 적용한 고성능 AI 모델로, DeepSeek-R1과 같은 대형 모델과 유사한 성능을 발휘하면서도, 적은 리소스로 실행할 수 있도록 최적화된 모델입니다. 그러면 바로 QwQ-32B의 주요 특징, 성능, 설치 및 실행 방법을 자세히 알아보겠습니다.

QwQ란

QwQ는 Qwen 시리즈의 추론 모델로, 기존의 명령어 학습 모델보다 뛰어난 사고 및 추론 능력을 갖추고 있습니다. 특히 어려운 문제에서 높은 성능을 발휘하며, 다양한 다운스트림 작업에서도 성능이 크게 향상됩니다. QwQ-32B는 320억 개의 매개변수를 가진 중간 크기의 모델로, 6710억 개의 매개변수(그 중 370억 개 활성화)를 보유한 DeepSeek-R1과 유사한 성능을 달성했습니다. 이는 방대한 세계 지식을 사전 학습한 강력한 기초 모델에 강화 학습(RL)을 적용할 경우, 그 효과가 매우 뛰어나다는 것을 입증하는 결과입니다. 또한, DeepSeek-R1, o1-mini와 같은 최신 최첨단 추론 모델과 경쟁할 수 있는 성능을 갖추고 있습니다.

- QwQ-32B 소개페이지 : https://qwenlm.github.io/blog/qwq-32b

강화 학습(RL)을 통해 QwQ 모델은 기존의 사전 학습 및 사후 학습 방식보다 더욱 향상된 성능을 발휘하며, 추론 능력을 크게 강화했습니다. 또한, QwQ-32B는 에이전트 관련 기능을 통합하여 환경의 피드백을 반영하고, 도구를 활용하며, 비판적 사고를 수행하는 능력을 갖추고 있습니다. 아래 링크를 통해 데모 버전을 사용해보실 수 있습니다.

- QwQ-32B 데모 버전 : https://huggingface.co/spaces/Qwen/QwQ-32B-Demo

경쟁 모델 비교

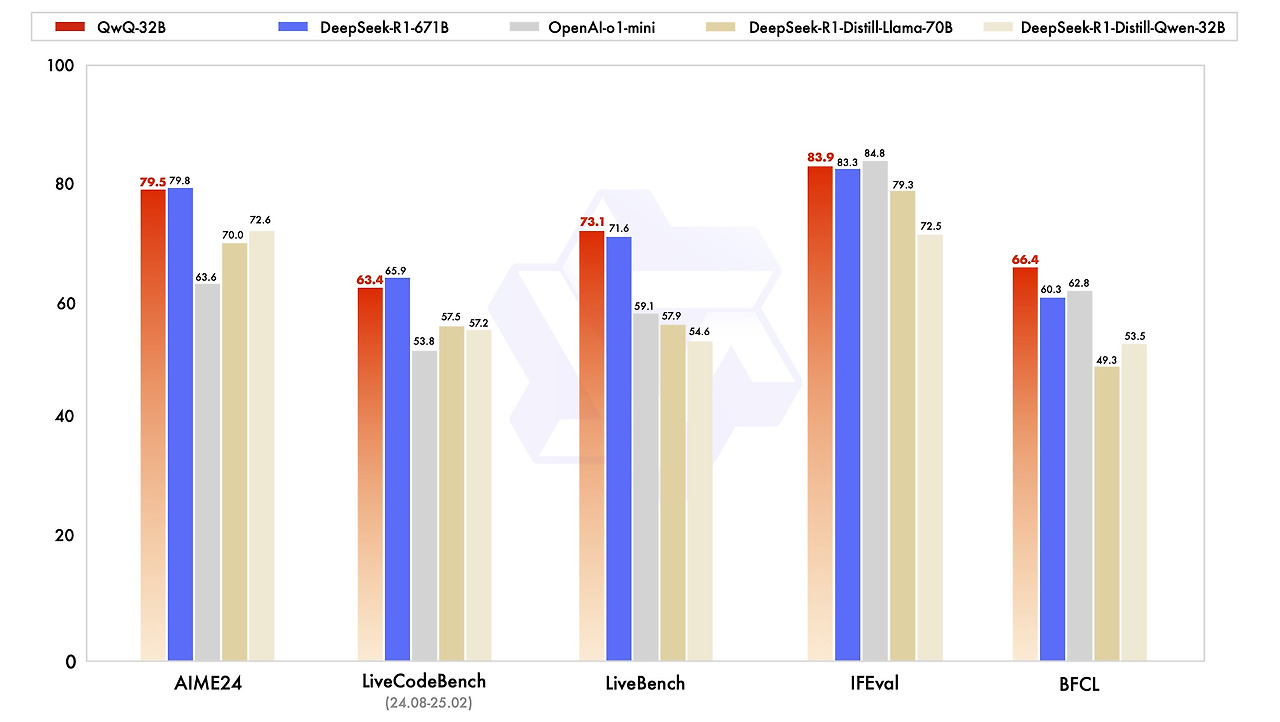

QwQ-32B 모델은 여러 평가 지표에서 DeepSeek-R1-671B와 유사하거나 더 나은 성능을 보여주었습니다.

- AIME24: 79.5점으로 DeepSeek-R1-671B(79.8점)와 거의 동등한 성능

- LiveCodeBench: 63.4점으로 DeepSeek-R1-671B(65.9점)보다 약간 낮지만, 다른 모델보다 우수

- LiveBench: 73.1점으로 DeepSeek-R1-671B(71.6점)보다 더 높은 성능

- IFEval: 83.9점으로 DeepSeek-R1-671B(83.3점)보다 높고, 일부 모델보다 약간 낮은 성능

- BFCL: 66.4점으로 DeepSeek-R1-671B(60.3점) 및 다른 모델보다 우수

전체적으로 QwQ-32B는 320억 개의 파라미터만으로도 6710억 개의 DeepSeek-R1-671B와 경쟁 가능한 성능을 발휘하며, 특히 LiveBench, IFEval, BFCL에서 강한 성능을 보였습니다.

QwQ-32B 모델의 주요 특징

- 강화 학습 기반의 추론 능력 : 강화 학습(RL)을 적용하여 논리적 사고와 문제 해결 능력을 강화, 수학 문제 해결 및 코드 생성 등 복잡한 작업에서 뛰어난 성능을 발휘

- 경량화된 구조 : 320억 개의 파라미터를 갖춘 중형 모델, DeepSeek-R1과 같은 대형 모델과 유사한 성능을 제공하면서도 더 적은 리소스로 실행 가능

- 고난이도 문제 해결 능력 : 수학, 코딩, 논리적 사고 영역에서 강력한 성능을 보이며, 특히 AIME 같은 수학 평가에서 높은 점수를 기록함.

- 효율적인 자원 사용 : 최적화된 모델 구조 덕분에 24GB VRAM 환경에서도 원활한 작동 가능

- 오픈소스 제공 : QwQ-32B는 허깅페이스에서 오픈 소스로 제공됨.

- 긴 컨텍스트 처리 : 최대 131,072 토큰까지 처리 가능, 긴 문서 분석 및 장문 생성 작업에서도 강력한 성능 발휘

라이선스

QwQ-32B 모델은 Apache License 2.0을 따르는 오픈소스 라이선스입니다. Apache License 2.0은 Apache Software Foundation(ASF)에서 제공하며, 누구나 자유롭게 사용, 수정, 배포할 수 있으며, 상업적 활용도 가능합니다. 또한, 특허 보호 조항이 포함되어 있어, 안전하게 사용할 수 있는 강력한 오픈소스 라이선스입니다.

사전 준비 사항

이 포스팅에서는 Ollama 프로그램의 설치 및 사용 방법을 다룰 예정입니다. Ollama 방식을 활용하려면 먼저 Ollama 프로그램을 설치해야 합니다. Ollama에서 제공하는 모델은 양자화된 모델이므로, 이를 활용하면 로컬 환경에서도 적은 리소스로 효율적이고 편리하게 사용할 수 있습니다.

- Ollama 설치 : https://ollama.com/download

목차

1. 실행 환경

2. QwQ 모델 다운로드

3. 실행

1. 실행 환경

- 운영체제 : Windows 11

- ollama : 0.3.12

- transformers : 4.45.2

- GPU : NVIDIA GeForce RTX 4060 Ti

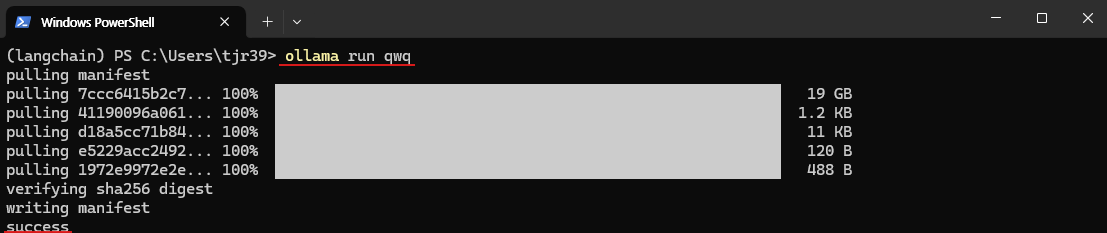

2. QwQ 모델 다운로드

Ollama가 정상적으로 설치되어 있다면, QwQ 모델을 다운로드하고 실행하는 과정이 매우 간단합니다. 아래 명령어를 사용하여 모델을 다운로드하고 설치할 수 있습니다.

# Windows PowerShell

ollama --version # Ollama가 정상적으로 설치되었다면 버전이 출력됩니다.

# 버전이 출력되지 않으면 Ollama를 다시 설치해야 합니다.

ollama run qwq # QwQ 모델 실행 (모델이 없는 경우 자동 다운로드)

3. 실행

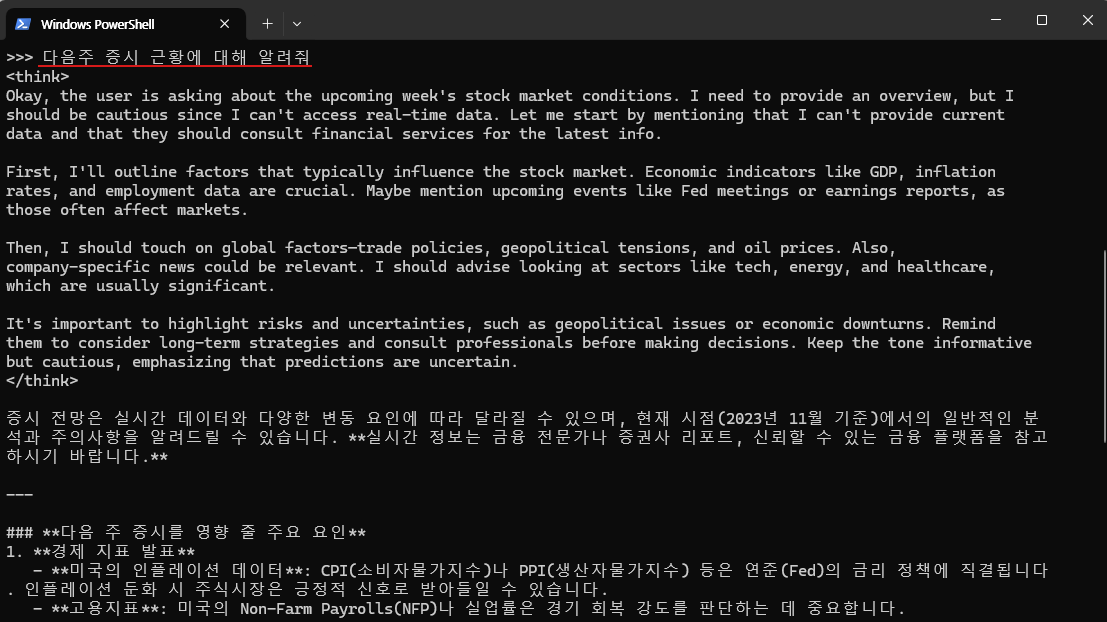

위 명령어를 사용하여 QwQ 모델을 정상적으로 다운로드 및 실행했다면, 이제 프롬프트 창에 질문을 입력하면 됩니다.

아래는 간단한 프롬프트를 입력하고 출력된 결과의 예시입니다.

- 사용 프롬프트 : 다음주 증시 근황에 대해 알려줘.

현재 사용 중인 컴퓨팅 성능으로도 QwQ 모델이 원활하게 로컬에서 실행되었으며, 실제 작동 과정에서도 안정적인 성능을 보였습니다. 실행 중 약 21GB의 VRAM이 사용되었으며, 모든 답변이 생성되는 데 약 1~2분 정도의 시간이 소요되었습니다.

특히, 오픈 소스로 공개된 모델임에도 불구하고 뛰어난 성능을 보여주었으며, 복잡한 질문에 대해서도 논리적인 답변을 생성하는 능력이 인상적이었습니다. 다만, 모델이 학습한 정보는 2023년 11월 기준으로 추정되기 때문에, 최신 정보나 실시간 데이터를 반영한 답변은 어렵다는 한계가 있습니다.

QwQ-32B는 강화 학습을 적용하여 강력한 추론 능력을 갖춘 AI 모델로, DeepSeek-R1과 유사한 성능을 발휘하면서도 더 적은 리소스로 실행할 수 있도록 최적화되었습니다. 또한, Apache 2.0 라이선스 기반의 오픈소스 모델로 제공되어, 누구나 자유롭게 활용하고 확장할 수 있습니다. AI 모델을 직접 실행해 보고 싶은 분들은 QwQ-32B를 활용하여 다양한 테스트를 진행해 보시길 추천드립니다.

앞으로도 AI 기술이 지속적으로 발전하면서, 더 효율적이고 강력한 모델들이 등장할 것입니다. QwQ-32B가 그러한 흐름 속에서 하나의 강력한 선택지가 될 수 있기를 기대합니다.

감사합니다. 😊

'AI 소식 > 오픈소스 AI 모델' 카테고리의 다른 글

| [오픈 소스 AI] [음성 생성 AI] 짧은 음성 하나면 목소리를 복제하는 AI, Spark-TTS를 소개합니다. (0) | 2025.03.21 |

|---|---|

| 구글의 온디바이스 모델 Gemma3를 소개합니다. (1) | 2025.03.19 |

| 국내 기업 카카오의 오픈 소스 AI 모델, Kanana를 소개합니다. (0) | 2025.03.05 |

| [오픈 소스 AI] [로컬 환경] 저용량 고성능의 SLM, Mistral Small 3를 소개합니다. (0) | 2025.02.13 |

| [오픈 소스 AI] Suno와 같이 노래를 생성 해주는 AI 모델, "YuE"를 소개합니다. (0) | 2025.02.10 |