안녕하세요,

최근 메타에서 또 하나의 새로운 LLM 모델을 출시했습니다. 이전에 공개된 Llama 3.1 405B 모델은 오픈소스임에도 불구하고 GPT-4o와 유사한 성능을 발휘한다는 평가를 받았으며, Llama 3.2 모델은 온디바이스 모델로도 활용할 수 있을 만큼 경량화되면서도 뛰어난 성능을 제공해 많은 주목을 받았습니다. 2024년이 끝나기 전에 메타는 Llama 3.3 모델을 추가로 선보였습니다. 이번 모델은 과연 어떤 특징을 가지고 있을지 함께 알아보겠습니다.

Llama 3.3

메타는 2024년 12월 6일 Llama 3.3 70B 모델을 공개했습니다. 이 모델은 같은 해 4월에 발표된 Llama 3의 하위 버전으로, 700억 개의 매개변수를 보유한 중형 언어 모델입니다. Llama 3.3 모델은 GPT-4o와 성능이 거의 같다고 알려진 Llama 3.1 405B 모델과 유사한 수준의 성능을 제공하면서도 실행이 간편하고 비용 효율성이 뛰어난 점이 특징입니다.

- Llama 3.3 공식페이지 : https://www.llama.com/

- Llama 3.3 출시 기사 : https://aimatters.co.kr/news-report/ai-news/9829

주요 특징

1) 성능과 효율성

- 고효율 중형 모델: 700억 개의 매개변수를 갖춘 Llama 3.3은 Llama 3.1 405B와 유사한 성능을 유지하면서도 실행이 간편하고 비용 효율적입니다.

- 저비용 운영: 운영 비용을 대폭 낮춰 100만 토큰당 0.01달러로, 경쟁 모델들보다 경제적입니다.

2) 벤치마크와 다국어 지원

- 우수한 테스트 성능: 휴먼이벨(HumanEval) 테스트에서 뛰어난 코딩 능력을 입증, MMLU와 IFeval 등 다양한 벤치마크에서도 업계 선두 모델들과 대등한 성능을 기록했습니다.

- 다국어 지원: 영어, 독일어, 프랑스어, 이탈리아어, 포르투갈어, 힌디어, 스페인어, 태국어 등 총 8개 언어를 지원하며 글로벌 환경에서도 강력한 활용성을 제공합니다.

- 추가 기능: JSON 출력, 단계별 추론, 프로그래밍 언어 지원 확대, 개선된 코드 피드백 등 다양한 기능을 포함하고 있습니다.

3) 경쟁 모델 대비 강점

- OpenAI GPT-4, Google Gemini 1.5, Amazon Nova Pro와 유사하거나 일부 벤치마크에서 우수한 성능을 발휘하며, 다양한 텍스트 중심 애플리케이션에 적합합니다.

라이선스

Llama 3.3은 상업적 및 연구 목적으로 자유롭게 사용이 가능합니다. 단, 월간 활성 사용자가 7억 명을 초과하는 제품이나 서비스를 개발할 경우, 메타로 별도의 라이선스를 요청해야 합니다. 이를 통해 대규모 상업적 활용이 필요한 기업들에게 적합하면서도 공정한 사용 정책을 유지합니다.

사전 준비 사항

이번 포스팅에서는 Ollama를 통해 Llama 3.3 모델을 설치하고 실행하는 방법에 대한 내용입니다. Ollama가 아직 설치되지 않으셨다면 아래 포스팅 내용을 확인하시고, Ollama 설치 후 진행해주시기 바랍니다.

- Ollama 설치 방법 : [Macus' Story] - 로컬 언어 모델의 시작, Ollama를 소개합니다.

목차

1. 실행 환경

2. Llama 3.3 모델 다운로드

3. Llama 3.3 모델 실행

1. 실행 환경

- 운영체제 : Windows 11

- Ollama : 0.3.12

- GPU : NVIDIA GeForce RTX 4060 Ti

2. Llama 3.3 모델 다운로드

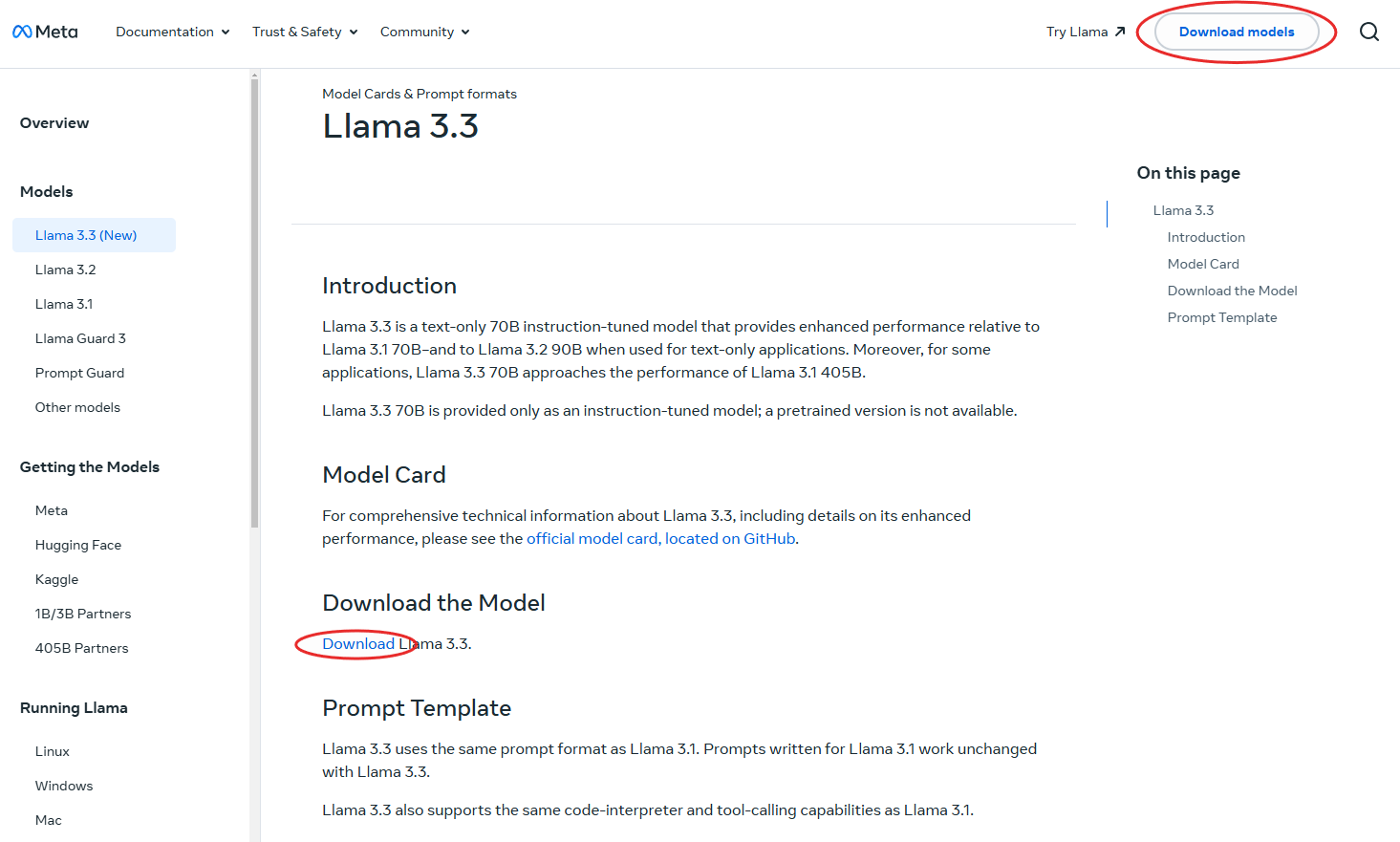

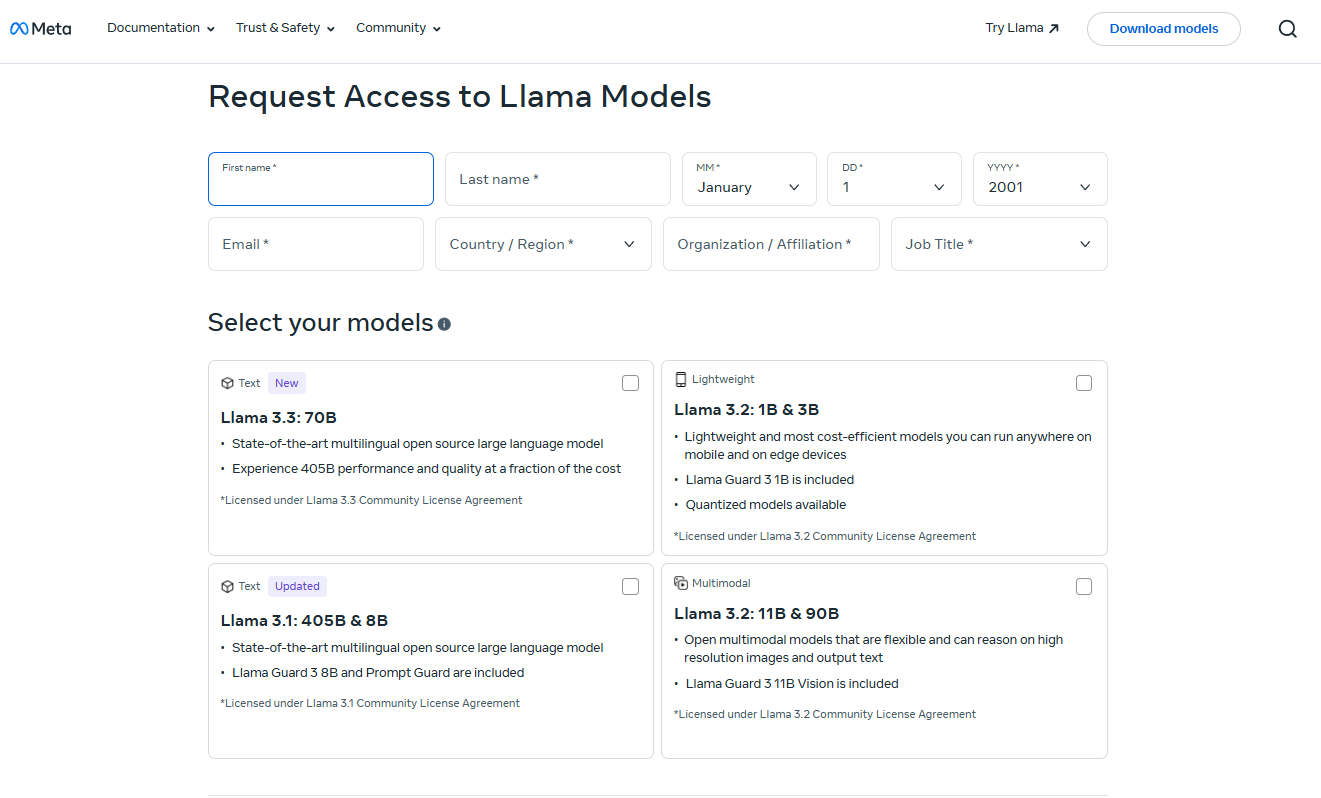

Llama 3.3 모델을 다운로드하는 방법은 두 가지입니다. 첫 번째는 공식페이지에서 신청서 작성 후 다운로드하시면 됩니다.

- Llama 3.3 모델 페이지 : https://www.llama.com/docs/model-cards-and-prompt-formats/llama3_3/

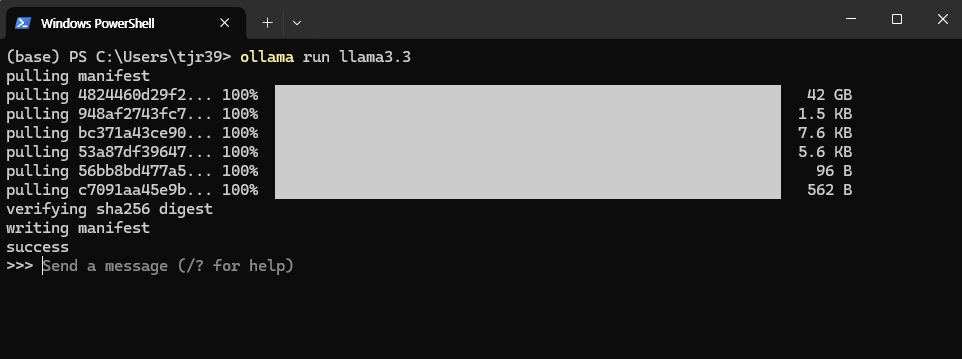

두 번째 방법은 Ollama를 사용하여 다운로드하는 방법입니다. 아래 명령어를 통해 Ollama 3.3 모델을 설치합니다.

# WindowsPowerShell

ollama run llama3.3 # llama 3.3 실행 (해당 모델이 없으면 다운로드)

3. Llama 3.3 모델 실행

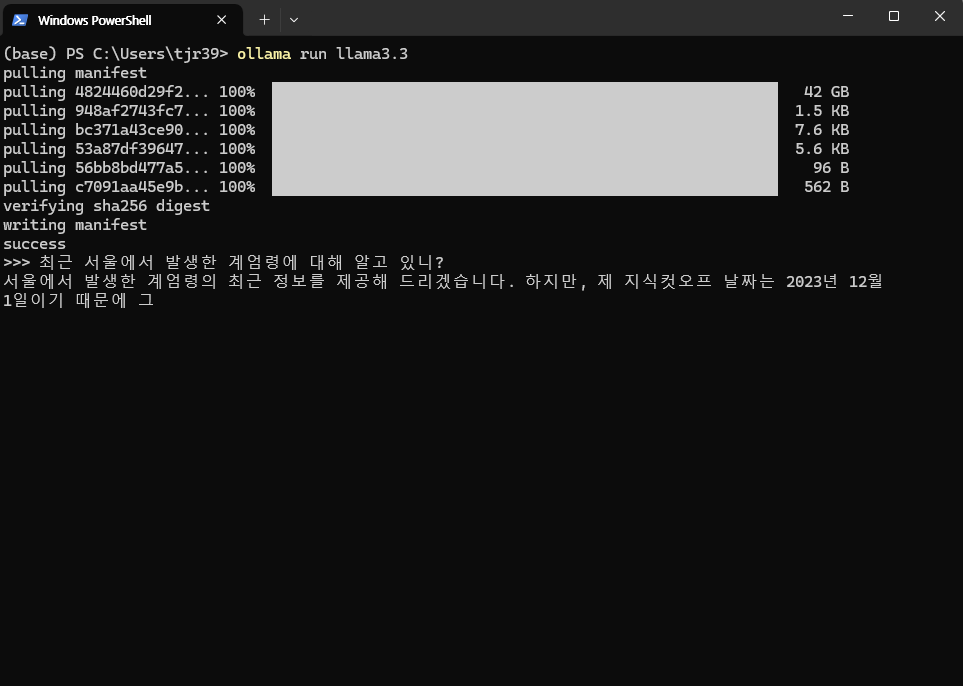

Llama 3.3 모델은 간단히 "Send a message" 입력란에 프롬프트를 입력하여 사용할 수 있습니다. 예를 들어, 최근 이슈가 되었던 계엄령에 대해 질문해 보았습니다. 하지만 답변을 생성하는데 시간이 너무 많이 소요되어 도중에 중지하였습니다.

70B 모델(이번 포스팅에서 다룬 모델)은 기본적으로 약 40GB의 VRAM을 요구한다고 알려져 있습니다. Ollama를 통해 실행해 본 결과, CPU와 GPU를 병행하여 작동은 했지만, 문장 한 줄을 생성하는 데도 상당히 긴 시간이 소요되었습니다. 또한, 이 모델이 학습한 데이터는 2023년까지의 정보를 기반으로 하고 있는 것으로 보입니다.

Llama 3.3은 뛰어난 성능과 효율성을 갖춘 모델로, 다양한 언어와 기능을 지원하며 텍스트 중심 애플리케이션에서 강력한 도구로 활용될 가능성을 보여줍니다. 특히, 여러 벤치마크에서 높은 평가를 받으며 최신 대규모 언어 모델들과 대등한 성능을 입증했습니다. 이러한 긍정적인 평가에 힘입어 로컬 환경에서 직접 실행해 보고자 했으나, 하드웨어 성능 부족으로 원활한 테스트를 진행하기는 어려웠습니다. 앞으로 더욱 최적화된 실행 환경이 갖춰진다면 이 모델의 잠재력을 직접 체험해 볼 수 있을 것으로 기대됩니다.

감사합니다. 😊

'AI 소식 > 오픈소스 AI 모델' 카테고리의 다른 글

| [오픈 소스 AI] 중국에서 개발한 무료 ChatGPT, DeepSeek를 소개합니다. (0) | 2025.01.08 |

|---|---|

| [오픈 소스 AI] 구글에서 발표한 기상 예보 AI, GenCast (젠캐스트)를 소개합니다. (0) | 2024.12.13 |

| [영상 생성 AI] [오픈 소스] [로컬 환경] Genmo에서 개발한 영상 생성 AI, Mochi-1를 소개합니다. (0) | 2024.10.31 |

| [오픈 소스 AI] [로컬 환경] 음성을 복제하여 텍스트를 음성으로 바꿔주는 AI, SWivid TTS(Text to Speech)를 소개합니다. (2) | 2024.10.20 |

| [오픈 소스 AI] [로컬 환경] OpenAI에서 개발한 음성 인식 AI, Whisper를 소개합니다. (1) | 2024.10.17 |