안녕하세요. 챗GPT의 등장 이후로 다양한 생성 AI 모델들이 개발되어 왔습니다. 초기에는 대규모 언어 모델(LLM)이 주를 이루었지만, 지금은 개인도 손쉽게 다룰 수 있는 소형 언어 모델(SLM)이 중심 트렌드로 자리 잡고 있습니다. 이는 AI 모델이 더 이상 대기업의 전유물이 아니며, 개인 개발자들에게도 접근 가능하게 되었다는 중요한 변화를 의미합니다. 여러분께 이러한 변화의 한 축을 담당하는 'Ollama', 소형 언어 모델을 쉽게 만들 수 있도록 돕는 AI 도구를 소개하겠습니다.

1. Ollama란

'Ollama'는 대규모 언어 모델을 로컬 컴퓨터에서 설정하고 실행할 수 있게 해주는 고급 AI 도구입니다. 이는 AI 기술의 민주화에 있어 중요한 발전으로, 사용자가 Llama 3나 gemma와 같은 언어 모델을 직접 활용할 수 있는 가능성을 제공합니다. 개발자, 연구자, 데이터 과학자에게 필수적인 다양한 자연어 처리(NLP) 애플리케이션에서 중요한 역할을 하는 'Ollama'는 가볍고 확장 가능한 프레임워크로, 복잡한 클라우드 기반 솔루션에 의존하지 않고도 모델의 기능을 로컬에서 직접 활용할 수 있도록 합니다. 이 도구는 언어 모델을 생성, 실행, 관리할 수 있는 간단한 API와 사전 구축된 모델 라이브러리를 제공하여 애플리케이션에 쉽게 통합할 수 있습니다. Ollama를 사용하면 Modelfile을 통해 모델 가중치, 구성, 데이터를 패키징하고 GPU 사용 등의 설정을 최적화할 수 있습니다.

2. Ollama 장점

- 로컬 실행: 대규모 언어 모델의 로컬 실행 가능, 사용자에게 빠르고 효율적인 AI 처리 기능 제공

- 다양한 모델 지원: (Meta)Llama3 , (Mcrosoft)Phi-3 , (Google)Gemma , mixtral, mistral ...

- 모델 커스터마이징: 자신만의 모델을 자유롭게 커스터마이징하고 제작 가능

- 사용자 친화적인 인터페이스: 도구의 디자인은 사용 편의성을 보장하여 빠르고 번거롭지 않은 설정 가능

- 다양한 시스템 환경 호환성: macOS, Windows, Linux 지원

3. Ollama 설치

Ollama 공식 사이트에서 설치파일 다운이 가능합니다.

- Ollama 공식 사이트 - https://ollama.com/download

Ollama는 macOS, Windows, Linux를 포함한 다양한 운영체제에서 사용할 수 있습니다. 여러분의 운영체제에 맞는 버전을 다운로드하여 설치해 주세요. 설치가 완료되면 터미널 창을 통해 바로 사용하실 수 있습니다.

4. 실행 명령어

Ollama terminal 기초 명령어

| ollama 명령어 | 실행 |

| ollama serve | ollama 시작 |

| ollama pull [model] | [model] 설치 |

| ollama run [model] | [model] 실행 |

| ollama list | 모델 리스트 출력 |

| ollama rm [model] | [model] 삭제 |

| /bye | [model] 실행 종료 |

| /? | 도움말 출력 |

| /show info | 현재 실행 모델 정보 출력 |

| /load [model] | [model] 불러오기 |

| /save [model] | [model] 저장하기 |

기타 명령어

| netstat -aon | 현재 실행중인 TCP 리스트 출력 |

| kill -9 [PID] | [PID] 서버 닫기 |

- 대괄호 [ ] : 예시 단어 (입력 시 상황에 맞게 수정해야합니다.)

5. 로컬 AI 모델 실행 예시

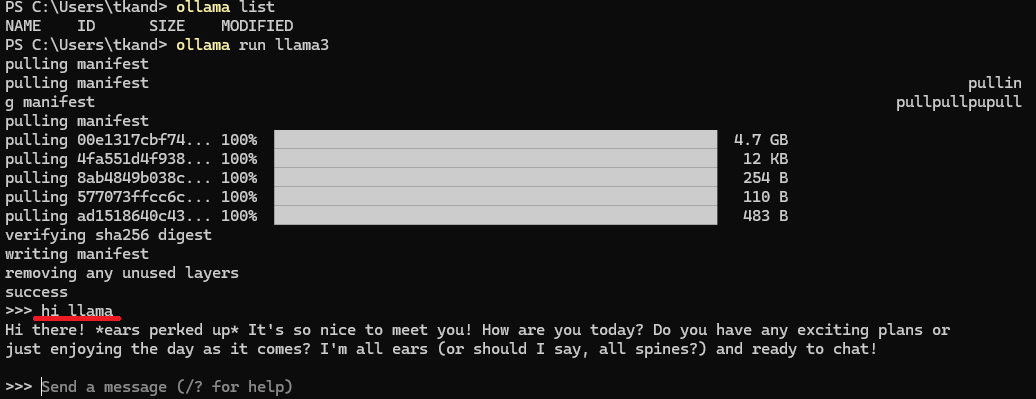

Ollama를 설치하신 후, 사용하실 AI 모델을 별도로 다운로드하셔야 합니다. 예를 들어, Ollama에서 지원하는 모델 중 하나인 'Llama3'을 설치하여 사용해 보겠습니다.

처음에는 ollama list 명령어를 사용하여 현재 설치된 AI 모델을 확인합니다. 만약 'Llama3' 모델이 없다면 ollama run llama3 명령을 통해 'Llama3' 모델을 다운로드하고 실행할 수 있습니다. 다운로드가 완료되면, 프롬프트에 메시지를 입력하라는 안내를 받게 됩니다.

"hi llama"라는 간단한 메시지를 입력하면, Llama3 모델이 정상 작동하는지 확인할 수 있습니다.

이것으로 로컬 환경에서 Llama3 모델이 잘 작동함을 알 수 있습니다.

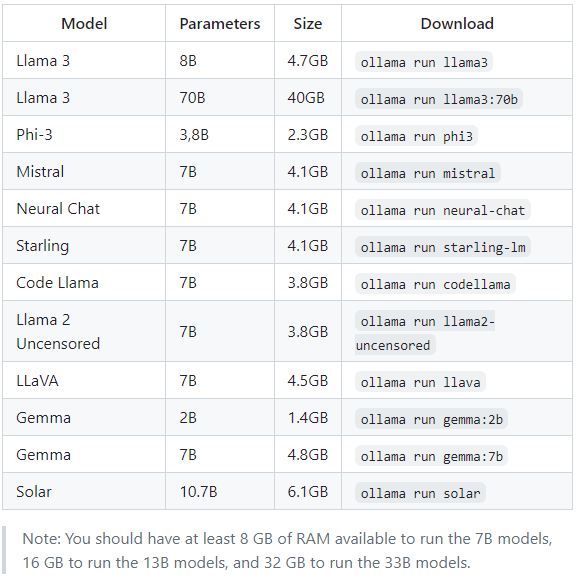

Ollama는 다양한 AI 모델을 지원합니다. 아래 이미지에는 Ollama가 제공하는 모델들 중 일부가 나열되어 있습니다. 더 많은 모델을 알고 싶으시다면 Ollama 라이브러리에서 상세히 살펴보실 수 있습니다.

챗GPT의 등장 이후 생성 AI 모델이 대중화되고 있습니다. 이제 개인도 쉽게 사용할 수 있는 소형 언어 모델(SLM)을 개발할 수 있는 시대가 왔습니다. 'Ollama'는 이러한 패러다임 전환의 중심에 있는 도구로, 복잡한 클라우드 서비스 없이도 우리의 로컬 환경에서 강력한 언어 모델을 직접 운영할 수 있게 해 줍니다. 사용자 친화적인 인터페이스로 여러분의 개별 요구에 맞춰 모델을 커스터마이징하고, macOS부터 Windows, Linux까지 다양한 시스템에서 구동할 수 있습니다. 이처럼 'Ollama'는 개인 개발자들에게 열린 AI의 문을 넓혀주고 있으며, 우리 모두가 AI의 혜택을 누릴 수 있는 토대를 마련해 주고 있습니다. AI 기술의 진보를 몸소 체험하고 싶은 분들에게 'Ollama'는 훌륭한 선택이 될 것입니다.

출처

- Ollama 공식 사이트 - https://ollama.com/

- Ollama 깃허브 - https://github.com/ollama/ollama#model-library

- LangChain Ollama 소개 - https://python.langchain.com/docs/integrations/llms/ollama/

Ollama

Get up and running with large language models.

ollama.com

'Ollama' 카테고리의 다른 글

| [오픈 소스 AI] [로컬 환경] 알리바바 클라우드에서 공개한 AI, Qwen 2.5를 소개합니다. (0) | 2024.10.08 |

|---|---|

| [오픈 소스 AI] [로컬 환경] 야놀자에서 개발한 AI 모델, EEVE 실행하기 1탄 (0) | 2024.05.10 |