안녕하세요,

최근 중국 딥시크가 이미지 속 문자를 정밀하게 인식하는 OCR 모델을 공개한 데 이어, 중국 바이두에서도 이미지 이해 능력을 강화한 멀티모달 모델을 발표했습니다. 이 모델은 일반적인 시각 정보 분석은 물론, 복잡한 기술 도면까지 해석할 수 있을 정도의 높은 성능을 보여주고 있습니다.

이번 포스팅에서는 바이두가 개발한 ERNIE-4.5-VL-28B-A3B 모델에 대해 알아보겠습니다.

ERNIE-4.5-VL-28B-A3B 모델이란

2025년 11월 11일, 중국 기업 바이두에서 최신 멀티모달 대형언어모델, ERNIE 4.5 VL 모델을 공개했습니다. 이 모델은 텍스트뿐 아니라 이미지(및 영상) 입력을 처리하며 시각·언어 간의 의미 정렬(semantic alignment)과 복잡한 시각-언어 추론 능력에 중점을 둔 설계입니다.

구체적으로, ‘Thinking’ 모드가 활성화되면 이미지 확대/검색 도구 호출(tool-calling) 등을 포함해 “생각하며 이미지 처리(Thinking with Images)”할 수 있는 기능을 탑재하였고, 이로 인해 복합 차트 분석, 기술 도면 해석, 시각 객체 위치 인식 등 고난도의 시각-언어 작업이 가능해졌습니다.

또한 이 모델은 총 280 억(28B)개 매개변수를 가진 “A3B” 구조 위에서 동작하지만 추론 시에는 활성화되는 파라미터가 약 30억(3B) 수준으로 설계되어 있어, 파라미터 효율을 중시한 경량화 접근도 채택하고 있습니다.

- ERNIE-4.5-VL 공식소개글 : https://ernie.baidu.com/blog/posts/ernie-4.5-vl-28b-a3b-thinking/

ERNIE-4.5-VL-28B-A3B-Thinking: A Breakthrough in Multimodal AI

We release ERNIE-4.5-VL-28B-A3B-Thinking, a multimodal reasoning model that achieves SOTA performance while activating only 3B parameters.

ernie.baidu.com

[모델 정보 요약]

| 항목 | 모델명 |

|

| 버전명 | ERNIE-4.5-VL-28B-A3B-PT | ERNIE-4.5-VL-28B-A3B-Thinking |

| 파라미터 수 | 3B / 28B (활성 파라미터 / 전체 파라미터) | |

| 개발사 | 바이두 (Baidu) | |

| 아키텍처 | 멀티모달 MoE(Mixture-of-Experts) 기반 LLM | 멀티모달 MoE 기반 LLM + Thinking 모드(이미지 확대·도구 호출 강화) |

| 컨텍스트 길이 | 131,072 token | 131,072 token |

| 특징 | · 텍스트·이미지 입력 처리 · 시각-언어 통합 이해 · 28B 구조이면서 3B 활성 파라미터 기반의 효율적 추론 |

· PT 버전 기능 + 고도화된 시각-언어 추론 · 이미지 확대(zoom-in) 및 이미지 검색 도구 호출 지원 · 영상 이해(temporal reasoning) 및 바운딩박스 기반 시각 grounding 강화 |

| 라이선스 | Apache-2.0 라이선스 | |

| 모델 경로 (허깅페이스) |

https://huggingface.co/baidu/ERNIE-4.5-VL-28B-A3B-PT/tree/main | https://huggingface.co/baidu/ERNIE-4.5-VL-28B-A3B-Thinking/tree/main |

주요 특징

- 시각-언어 복합 추론 강화 : 이미지와 텍스트를 결합해 복수 단계(multi-step)로 추론하고, 인과관계(causal reasoning)나 차트(chart) 분석 등이 가능하도록 대규모 비전-언어 추론 데이터로 중간 학습(mid-training)을 수행하였습니다.

- Tool 활용 및 이미지 확대 기능 : ‘Thinking with Images’ 기능을 통해 이미지 내 특정 영역으로 확대(zoom)하거나 외부 이미지 검색(image search) 도구를 호출해 긴 꼬리(long-tail) 시각 지식까지 탐색할 수 있도록 설계되었습니다.

- 시각 객체 위치 인식 및 구조화된 출력 : 예컨대 여러 인물 중 정장을 입은 사람을 탐지해 JSON 형식의 바운딩 박스(bounding boxes)를 출력하는 등, 언어 지시(instruction)와 시각 grounding을 결합하는 작업에서 유연성을 보입니다.

- 영상 이해(Video Understanding) : 영상의 시간 축(temporal axis) 상의 변화를 분석하고, 특정 장면(scene)을 시간대(timestamp)로 도출하는 기능이 탑재되었습니다.

- 효율적 파라미터 활용 구조 : 전체 매개변수는 28B 수준이지만, 실제 추론 시 활성화되는 파라미터를 ~3B 수준으로 설계해 메모리·연산 효율을 향상시킨 구조입니다.

벤치마크 성능

바이두는 ERNIE-4.5-VL-28B-A3B-Thinking 모델의 벤치마크 성능을 공개했습니다. 이 모델은 다양한 멀티모달 평가에서 일관된 강세를 보이며, 수학적 시각 추론과 차트 분석, 문서 기반 질의응답 등 핵심 영역에서 경쟁력 있는 성능을 기록했습니다. 또한 이미지 텍스트 인식과 일반 시각 질의응답에서도 안정적인 결과를 보여, 폭넓은 시각·언어 과제를 균형 있게 처리하는 능력을 확인할 수 있습니다. 이러한 성능은 경량화된 구조를 유지하면서도 시각·언어 통합 능력을 정교하게 강화한 모델 설계의 효과를 잘 보여줍니다.

| 벤치마크 | ERNIE-4.5-VL-28B- A3B-Thinking |

Gemini-2.5-Pro | GPT-5-High |

| MathVista (이미지 기반 수학·도형·추론 문제 해결 능력) |

82.5 | 82.7 | 81.3 |

| MMMU (멀티도메인 멀티모달 일반지능 평가, 30+ 분야 종합 테스트) |

72.2 | 81.7 | 84.2 |

| ChartQA (차트·그래프 정보 읽기 및 질의응답 능력) |

87.1 | 76.3 | 78.2 |

| DocVQA (val) (문서·텍스트 이미지 기반 이해 및 질의응답) |

93.6 | 91.2 | 94.2 |

| OCRBench (이미지 속 텍스트 인식 및 정확도 평가) |

85.8 | 86.6 | 81.0 |

| MMStar (광범위한 멀티모달 지능 종합 평가, 6대 영역 포함) |

71.1 | 77.5 | 76.4 |

| BLINK (장면 이해·객체 관계 파악·일반 비전 QA) |

62.8 |

70.6 | 71.0 |

출처 : ERNIE-4.5-VL 공식소개글

라이선스

ERNIE-4.5-VL-28B-A3B 모델은 Apache License 2.0을 기반으로 공개된 모델입니다. 이 라이선스는 사용과 배포에 대한 제약이 비교적 적은 오픈소스 라이선스로, 상업적 활용이 명확하게 허용되는 점이 가장 큰 특징입니다. 기업이나 개인이 모델을 기반으로 한 서비스 개발, 제품 탑재, 연구·상용 솔루션 구축 등 다양한 방식으로 자유롭게 활용할 수 있으며, 로열티나 사용료와 같은 비용이 요구되지 않습니다.

다만 아파치 2.0 라이선스 조건에 따라, 모델을 사용하거나 수정하여 배포할 경우에는 라이선스 전문 포함, 저작권 고지 유지, 변경 사항 명시 등의 의무가 적용됩니다. 이러한 조건만 준수한다면 모델 자체를 상업 시스템에 통합하거나 파생 모델을 제작하는 데 별도의 제한이 없습니다.

요약하자면, ERNIE-4.5-VL-28B-A3B 모델은 상업적 활용에 매우 유연한 라이선스를 채택하고 있어, 기업에서도 부담 없이 도입 가능한 형태입니다.

간단한 사용 예시

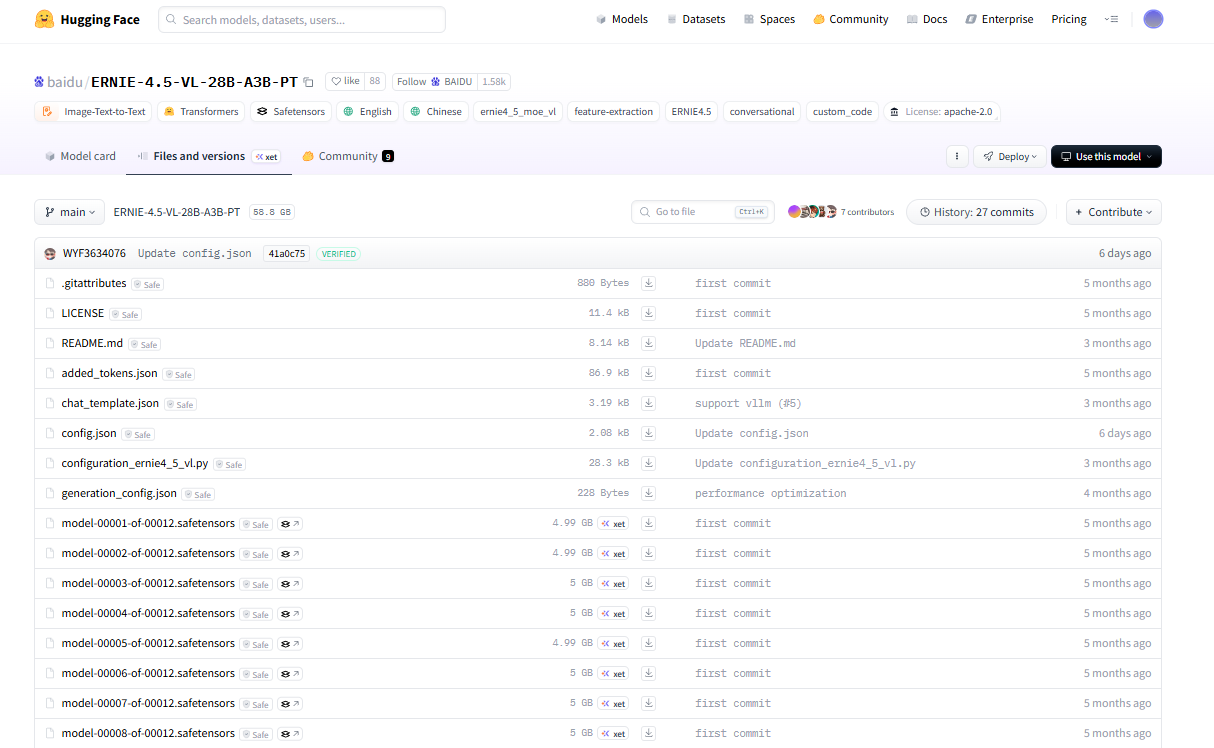

ERNIE-4.5-VL-28B-A3B 모델은 허깅페이스를 통해 테스트하거나 로컬 환경에 다운로드하여 직접 활용할 수 있습니다. PT 버전과 Thinking 버전 모두 오픈소스로 공개되어 있으나, 현재 허깅페이스 스페이스 환경에서 바로 실행해볼 수 있도록 제공되는 모델은 PT 버전으로 한정되어 있습니다.

1. 로컬 플랫폼 (오픈소스 실행 환경)

- 목적: 독립적 환경에서 모델 커스터마이징 및 실험

- 방법: 바이두 허깅페이스에서 모델 파일(.safetensors 등) 다운로드 (https://huggingface.co/baidu/ERNIE-4.5-VL-28B-A3B-PT/tree/main)

- 사용 방식: transformers, vLLM 등 프레임워크를 이용해 로컬 GPU에서 실행

- 특징: 인터넷 연결 불필요, 데이터 프라이버시 강화, 개발자·연구자에 적합

2. 베타 테스트 환경 (PT 버전만 제공)

- 목적: 정식 배포 전 기능 검증 및 체험

- 방법: 바이두 허깅페이스 (https://huggingface.co/baidu/ERNIE-4.5-VL-28B-A3B-PT)

- 사용 방식: 웹 기반 간단 입력창에서 실험적 기능 체험

- 특징: 제한된 기능, 모델 업데이트가 빈번, 공개 피드백 수집용

ERNIE-4.5-VL-28B-A3B 모델은 복잡한 시각 정보를 구조적으로 해석하고 언어적 추론과 결합하는 기능을 갖추어 다양한 작업 환경에서 활용 가치가 높은 모델입니다. 실제 이미지 분석, 문서 이해, 기술 도면 해석과 같은 정밀한 작업에서도 적용 가능성이 있으며, 여러 분야에서 확장된 활용을 기대할 수 있습니다.

또한 이 모델은 Apache 2.0 기반의 오픈소스로 공개되어 있어 활용 범위가 넓은 편입니다. 누구나 자유롭게 연구와 개발에 적용할 수 있다는 점에서 접근성이 높으며, 이러한 개방형 기술은 멀티모달 모델의 발전과 확산을 촉진하는 기반으로 이어질 것으로 예상됩니다.

감사합니다. 😊

'AI 소식 > 오픈소스 AI 모델' 카테고리의 다른 글

| [오픈소스 AI] Mistral 3 시리즈 공개, 로컬에서도 비전 인식이 가능한 오픈소스 AI 모델 (0) | 2025.12.09 |

|---|---|

| [오픈소스 AI] 국내 수퍼톤이 공개한 초고속 온디바이스 TTS 모델, Supertonic을 소개합니다. (0) | 2025.11.23 |

| [오픈소스 AI] Moonshot AI의 추론형 모델, Kimi-K2-Thinking 공개 (0) | 2025.11.12 |

| [한국어 AI 모델] 모티프 테크놀로지 Motif 2 특징과 간단한 사용 가이드 | 로컬환경 | 오픈소스 AI (0) | 2025.11.07 |

| [오픈소스 AI] ChronoEdit, NVIDIA가 선보인 최신 이미지 수정 모델 (0) | 2025.11.06 |