안녕하세요,

최근 중국 AI 기업 MiniMax에서 공개한 오픈소스 언어모델 MiniMax-M2가 전 세계 AI 커뮤니티에서 큰 주목을 받고 있습니다. 이 모델은 초거대 언어모델 구조를 기반으로 개발되었으며, 현재 공개된 오픈소스 모델 중에서도 가장 높은 수준의 성능을 보이고 있습니다. 특히 코드 생성, 자동화, 에이전트 워크플로우 등 다양한 분야에서 활용할 수 있도록 설계되어, 개발자와 연구자 모두에게 실질적인 가치를 제공하고 있습니다.

이번 포스팅에서는 MiniMax-M2 모델의 주요 특징과 활용 방식에 대해 알아보겠습니다.

MiniMax-M2 모델이란

2025년 10월 27일, MiniMax에서 에이전트 기능과 코드 기반 워크플로우 수행에 최적화된 새로운 언어모델 MiniMax-M2를 공개했습니다. 이 모델은 복수의 도구 호출을 통해 복잡한 작업을 스스로 계획하고 실행할 수 있는 행위 중심의 AI 구조를 지니며, 프로그래밍·스크립트 실행·백엔드 개발 등 코드 중심 업무에 강점을 보입니다. 또한 모델의 가중치가 오픈소스로 공개되어 개발자가 직접 배포하거나 로컬 환경에서 운영할 수 있는 유연성을 제공합니다.

- MiniMax 공식페이지 : https://www.minimax.io/

MiniMax AI | AGI-Powered Foundation Models & Voice/Text/Image/Video Tools

Build with next-gen AGI: MiniMax offers Foundation AI models (text/audio/image/video). Power products like Talkie, Hailuo AI & enterprise APIs. Scalable, secure AI solutions for 50K+ global businesses.

www.minimax.io

[모델 정보]

| 항목 | MiniMax-M2 모델 |

| 파라미터 수 | 활성 파라미터 100억 개(10 B) / 전체 파라미터 2,300억 개(230 B) |

| 개발사 | MiniMax AI |

| 아키텍처 | - “Agentic & Coding Workflows”에 최적화된 MoE(Mixture-of-Experts) 방식으로 설계 - 계획(Plan) → 실행(Act) → 검증(Verify) 루프 기반 구조 |

| 특징 | - 코딩 및 멀티툴 호출 워크플로우에 강점이 있으며, 에이전트 역할 수행 능력이 강화되어 있습니다. - 활성화 파라미터 10 B라는 구조 덕분에 저지연·고처리량 환경에 적합하게 설계되었습니다. - 상업적 사용 및 로컬 배포를 포함한 오픈소스 활용이 가능합니다. |

| 라이선스 | MIT 라이선스 적용되어 있으며, 자유로운 수정·배포·상업적 사용을 허용 |

| 서비스 플랫폼 | - 공식플랫폼 : https://agent.minimax.io/ - 허깅페이스 : https://huggingface.co/MiniMaxAI/MiniMax-M2 - API : https://platform.minimax.io/docs/guides/text-generation |

주요 특징

M2모델은 다음과 같은 특징을 중심으로 설계 및 제공되고 있습니다.

- 코딩 및 툴 사용 우수성: 프로그래밍, 셸, 브라우저, 파이썬 코드 인터프리터 등 다양한 도구를 조합하여 복잡한 작업을 처리할 수 있도록 설계됨.

- 높은 속도와 비용 효율성: 해외 유력 모델 대비 약 8 % 수준의 가격으로 제공되며, 추론 속도는 약 두 배 수준으로 제시됨.

- 강화된 에이전트 성능: 대량의 도구 호출과 연쇄적 작업을 안정적으로 처리할 수 있도록, 계획과 실행 측면에서 뛰어난 성능을 갖춤.

- 표준 벤치마크 상위권: 10개 테스트 작업으로 구성된 벤치마크에서 글로벌 상위 5위권에 진입하였음.

- 다양한 배포 및 사용 옵션: API를 통한 클라우드 호출, 무료 체험 제공, 로컬 배포 가능 등 사용 환경이 유연함.

벤치마크 성능

이번 벤치마크는 주요 언어모델의 코드 이해, 추론, 정보 탐색 능력을 종합적으로 비교한 결과입니다. MiniMax-M2는 대부분의 항목에서 안정적인 성능을 보였으며, 특히 τ²-bench와 GAIA(text only)에서 높은 점수를 기록했습니다. 전반적으로 코드 처리와 논리적 사고 능력에서 균형 잡힌 성능을 보인 오픈소스 모델로 평가됩니다.

| 벤치마크 항목 | 오픈소스 모델 | 상업 모델 | |||||

| MiniMax- M2 |

DeepSeek- V3.2 |

GLM-4.6 | Kimi K2 0905 |

Gemini 2.5 Pro |

Claude Sonnet 4.5 |

GPT-5 (thinking) |

|

| SWE-bench Verified |

69.4 | 67.8 | 68.0 | 69.2 | 63.8 | 77.2 | 74.9 |

| Multi-SWE- bench |

36.2 | 30.6 | 30.0 | 33.5 | – | 44.3 | – |

| Terminal- bench |

46.3 | 37.7 | 40.5 | 44.5 | 25.3 | 50.0 | 43.8 |

| Artifacts- bench |

66.8 | 55.8 | 59.8 | 54.2 | 57.7 | 61.5 | 73.0 |

| τ²-bench | 77.2 | 66.7 | 75.9 | 70.3 | 59.2 | 84.7 | 80.1 |

| GAIA (text only) |

75.7 | 63.5 | 71.9 | 60.2 | 60.2 | 71.2 | 76.4 |

| Browse Comp |

44.0 | 40.1 | 45.1 | 14.1 | 9.9 | 19.6 | 54.9 |

| FinSearch Comp- global |

65.5 | 26.2 | 29.2 | 29.5 | 42.6 | 60.8 | 63.9 |

출처 : MiniMax-M2 공식소개글

- SWE-bench Verified : 소프트웨어 엔지니어링 환경에서 버그 수정과 코드 이해 능력을 검증하는 지표

- Multi-SWE-bench : 복수의 코드 저장소와 다양한 언어 환경에서 문제 해결 능력을 측정하는 확장형 SWE 벤치마크

- Terminal-bench : 명령줄(Command Line) 환경에서 도구 사용 및 터미널 기반 작업 처리 능력을 평가하는 지표

- Artifacts-bench : 소프트웨어 개발 산출물(Artifacts) 생성 및 관리 능력을 평가하는 벤치마크

- τ²-bench (Tau²-bench) : 논리 추론과 수학적 문제 해결 능력을 중심으로 모델의 복합적 사고력을 측정하는 테스트

- GAIA (text only) : 텍스트 기반 상식·추론·지식 응용 능력을 평가하는 벤치마크

- BrowseComp : 웹 탐색과 정보 수집 능력을 측정하여, 모델이 외부 자료를 분석해 정확한 답을 도출할 수 있는지를 평가하는 지표

- FinSearchComp-global : 글로벌 금융·경제 관련 데이터의 검색 및 분석 능력을 평가하는 벤치마크

라이선스

MiniMax-M2는 MIT 라이선스를 적용받는 오픈소스 모델로, 상업적 사용이 전면적으로 허용됩니다. 기업이나 개인 개발자는 별도의 라이선스 비용이나 제약 없이 모델을 제품, 서비스, 또는 상용 애플리케이션에 자유롭게 통합할 수 있습니다. 또한 모델의 수정, 재배포, 파인튜닝 역시 허용되므로, 자사 환경에 맞춘 맞춤형 AI 시스템 구축이 가능합니다.

즉, MiniMax-M2는 상업적 활용을 전제로 한 오픈소스 모델로, 연구 목적을 넘어 실제 비즈니스 서비스에 직접 적용할 수 있는 실질적 이점을 제공합니다.

간단한 사용 예시

MiniMax-M2는 웹 기반 체험부터 로컬 실행, 그리고 API 연동까지 다양한 방식으로 활용할 수 있습니다. 별도의 복잡한 설정 없이 빠르게 테스트할 수 있으며, 개발 환경에 맞게 확장하거나 서비스에 직접 통합하는 것도 가능합니다.

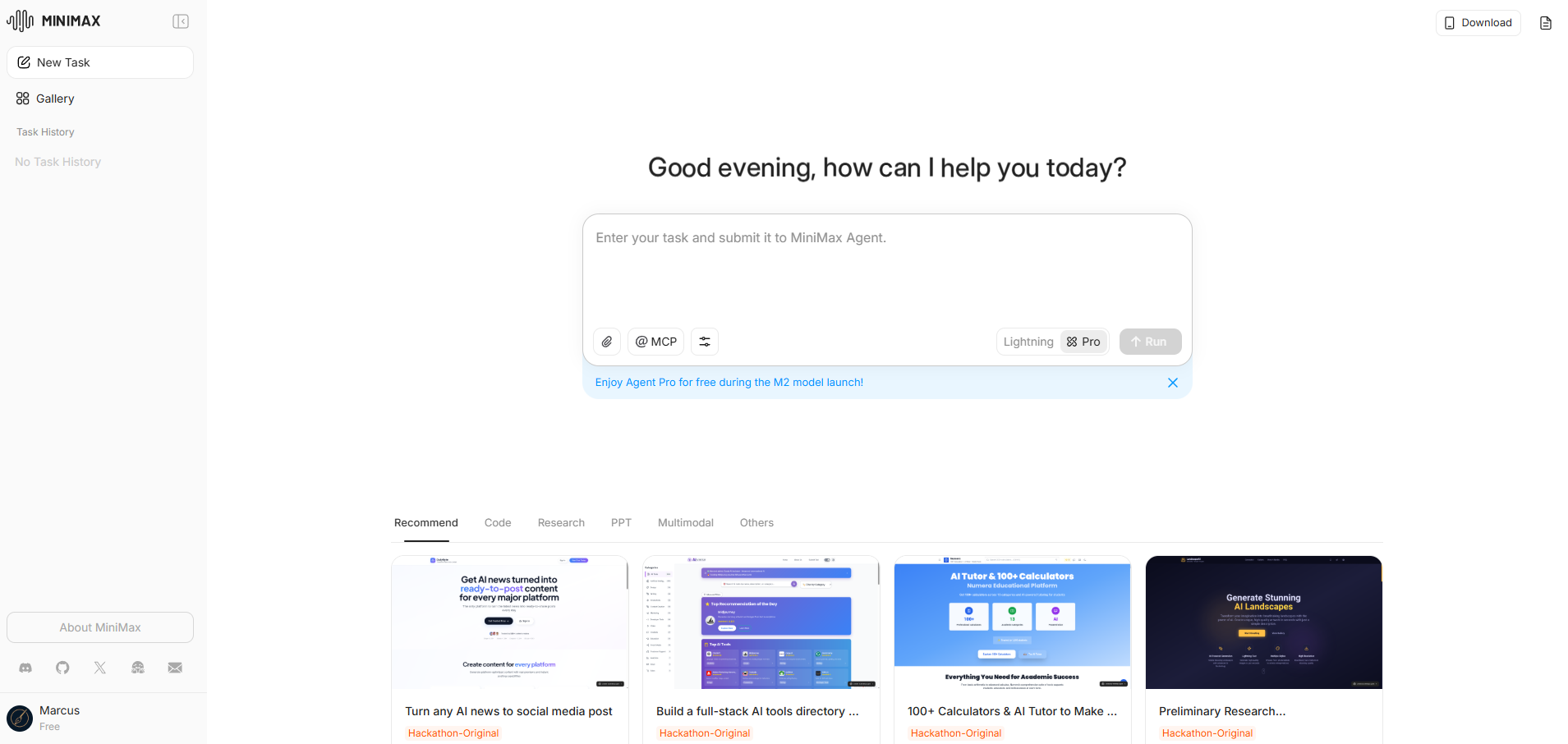

1. MiniMax 웹 플랫폼

MiniMax 공식 웹사이트에서는 별도의 설치 없이 브라우저에서 바로 모델을 체험할 수 있습니다. 로그인 후 텍스트를 입력하면 코드 생성, 질의응답, 문서 분석 등 다양한 기능을 이용할 수 있으며, 일반 모드와 Pro 모드 모두 무료로 제공됩니다. (Pro 모드는 무료 사용량에 일정한 제한이 있습니다.) 또한 Pro 모드에서는 각 답변에 정보 출처가 함께 표시되어, 보다 신뢰성 있는 결과를 확인할 수 있습니다.

- MiniMax 공식플랫폼 : https://agent.minimax.io/

2. 로컬 환경 (오픈소스)

공개된 오픈소스 모델 가중치를 다운로드하여 로컬 GPU나 서버 환경에서 직접 실행할 수 있습니다. 개발자는 이를 기반으로 모델을 커스터마이징하거나 파인튜닝하여 내부 시스템에 통합할 수 있으며, 세부 구조나 파라미터를 조정해 특정 비즈니스나 연구 목적에 맞게 최적화할 수 있습니다.

MiniMax-M2는 약 230GB 규모의 대형 모델로, 고성능 GPU 리소스를 필요로 하기 때문에 일반적인 개인 PC보다는 워크스테이션이나 클라우드 환경에서의 운용이 보다 적합합니다. 이러한 특성 덕분에 대규모 데이터 처리, 코드 자동화, 연구용 실험 등 고난도 작업에 활용하기에 유리한 구조를 갖추고 있습니다.

- MiniMax 허깅페이스 모델 경로 : https://huggingface.co/MiniMaxAI/MiniMax-M2/tree/main

- MiniMax 모델 사용 방법 : https://huggingface.co/MiniMaxAI/MiniMax-M2#local-deployment-guide

3. API

MiniMax API를 통해 MiniMax‑M2 모델을 외부 애플리케이션에 연동할 수 있습니다. RESTful 형식의 프로토콜을 지원하며, 개발자는 자동화된 코드 생성, 데이터 분석, 에이전트 호출 등 다양한 서비스에 활용할 수 있습니다. 문서에 따르면 본 API는 Anthropic 호환 API 또는 OpenAI 호환 인터페이스를 통해 호출할 수 있습니다. 자세한 내용은 아래 공식 링크에서 확인해 주시기 바랍니다.

- MiniMax API : https://platform.minimax.io/docs/guides/text-generation

# Python

import anthropic

client = anthropic.Anthropic(

base_url="https://api.minimax.io/anthropic",

api_key="Your MiniMax API Key",

)

message = client.messages.create(

model="MiniMax-M2",

max_tokens=1024,

messages=[

{

"role": "user",

"content": "Explain machine learning in simple terms"

}

]

)

print(message.content[0].text)

MiniMax-M2는 현재 공개된 오픈소스 언어모델 중에서도 가장 우수한 성능을 갖춘 모델로 평가됩니다. 에이전트 기반 구조를 중심으로, MCP와 같은 확장형 연결 기능을 지원하며, 웹 검색을 통한 실시간 정보 탐색도 가능합니다. 이러한 다층적 기능 통합은 단순한 언어 생성 능력을 넘어, 실제 문제 해결과 데이터 활용까지 아우르는 차세대 오픈소스 AI의 방향을 제시하고 있습니다.

앞으로는 MiniMax-M2와 같은 고성능 오픈소스 모델을 중심으로 AI 기술의 발전 속도가 한층 더 빨라질 것으로 예상됩니다. 기업과 개발자들이 자유롭게 모델을 확장하고 개선함에 따라, 다양한 형태의 새로운 모델들이 지속적으로 등장할 것으로 기대됩니다.

감사합니다. 😊

'AI 소식 > 오픈소스 AI 모델' 카테고리의 다른 글

| [오픈소스 AI] ChronoEdit, NVIDIA가 선보인 최신 이미지 수정 모델 (0) | 2025.11.06 |

|---|---|

| [오픈소스 AI] 최고 성능의 OCR 모델, Chandra-OCR를 소개합니다. (0) | 2025.11.03 |

| [오픈소스 AI] 1GB 미만의 초소형 비전-언어 모델, LFM2-VL을 소개합니다. (0) | 2025.10.30 |

| [오픈소스 AI] DeepSeek에서 공개한 이미지를 인식하는 AI 모델, DeepSeek-OCR을 소개합니다. (1) | 2025.10.24 |

| Z.AI GLM-4.6 공개 | Claude Sonnet 4를 능가한 차세대 오픈소스 LLM (0) | 2025.10.14 |