안녕하세요,

이전에 알리바바에서 공개한 Wan 2.2 모델을 소개한 적이 있습니다. 이 모델은 텍스트 입력만으로 영상을 생성할 수 있는 모델로, 가벼운 모델 크기에도 불구하고 뛰어난 생성 품질과 우수한 성능으로 많은 관심을 받았습니다. 이번에는 이 모델이 한 단계 발전하여, 이미지와 오디오 입력을 함께 활용해 더욱 원하는 영상 결과를 만들 수 있는 기능을 갖추게 되었습니다.

이번 포스팅에서는 새로운 Wan 2.2-S2V 모델에 대해 자세히 알아보겠습니다.

참고 : [Marcus' Story] - [ComfyUI + Wan 2.2] AI 영상 생성 오픈소스, Wan 2.2 사용법 | ComfyUI로 로컬에서 실행하기

Wan2.2-S2V 모델이란

Wan2.2-S2V는 정적 이미지와 오디오를 함께 활용하여 영상 콘텐츠를 자동으로 생성하는 최신 멀티모달 AI 비디오 생성 모델입니다. 이전 버전인 Wan2.2가 텍스트와 이미지를 기반으로 영상 생성이 가능했다면, 이번 업데이트에서는 오디오 입력 기능이 추가되어 보다 사실적인 장면 전개와 몰입감 있는 영상 제작이 가능합니다. 이를 통해 사용자는 단순한 이미지 기반의 영상이 아니라, 원하는 분위기·대사·효과음 등을 반영한 맞춤형 영상 결과물을 얻을 수 있습니다.

- Wan2.2 깃허브 : https://github.com/Wan-Video/Wan2.2

GitHub - Wan-Video/Wan2.2: Wan: Open and Advanced Large-Scale Video Generative Models

Wan: Open and Advanced Large-Scale Video Generative Models - Wan-Video/Wan2.2

github.com

주요 특징

- 멀티모달 입력 지원

텍스트, 이미지, 오디오를 동시에 입력하여 더 풍부한 스토리텔링과 표현이 가능합니다. - 고품질 영상 생성

소규모 모델임에도 불구하고 자연스러운 장면 전환과 높은 해상도의 영상 결과를 제공합니다. - 오디오 동기화 기능

입력한 오디오의 타이밍에 맞추어 캐릭터의 움직임이나 장면을 조정해 보다 자연스러운 결과를 얻을 수 있습니다. - 로컬·클라우드 실행 가능

ComfyUI 등 오픈소스 워크플로우에서 로컬 실행이 가능하며, API 형태로도 활용할 수 있습니다. - 빠른 처리 속도

모델 최적화를 통해 프레임 생성 속도가 개선되어 실험과 반복 작업이 용이합니다.

라이선스

이 모델은 Wan2.2 모델과 동일하게 Apache 2.0 라이선스로 공개되어 누구나 자유롭게 활용할 수 있습니다. Apache 2.0은 상업적 활용을 명시적으로 허용하는 오픈소스 라이선스로, 기업이나 개인이 이 모델을 이용해 상업용 애플리케이션, 서비스, 콘텐츠를 제작·배포할 수 있습니다. 또한 라이선스 조건에 따라 원저작자 표기와 라이선스 사본 포함 의무만 준수하면, 모델의 수정·재배포 역시 자유롭게 가능합니다.

사전준비사항

이 포스팅에서는 ComfyUI와 Wan2.2 모델을 사용하여 영상 생성 방법을 소개합니다. 본문을 따라 하기 전에 아래의 필수 항목들을 미리 설치해 주시기 바랍니다.

[Stabiliy Matrix&ComfyUI 설치하기] (포스팅에서 사용한 방식)

- ComfyUI 설치: [Marcus' Story] - [ComfyUI] 초보자도 쉽게 따라하는 Stability Matrix 활용하기

- ComfyUI-Manager 설치: [Marcus' Story] - [ComfyUI] Stability Matrix에 ComfyUI-Manager 설치하기

[로컬에 직접 ComfyUI 설치하기]

- ComfyUI 설치: [Marcus' Story] - [ComfyUI] [로컬 환경] ComfyUI 로컬 환경에 설치 및 실행 방법

- ComfyUI-Manager 설치: [Marcus' Story] - [ComfyUI] [로컬 환경] ComfyUI 관리 도구, ComfyUI-Manager 설치하기

목차

1. 실행 환경

2. ComfyUI 사용 노드

3. Wan2.2-S2V 모델

- Workflow 다운로드

- 모델 다운로드

- 실행 (영상 생성)

1. 실행 환경

- 운영체제 : Windows 11

- ComfyUI : 0.3.59

- ComfyUI-Manager : V3.30

- Python : 3.10.11

- torch : 2.8.0 + cu128

- GPU : NVIDIA GeForce RTX 4060 Ti (vram : 16GB)

2. ComfyUI 사용 노드

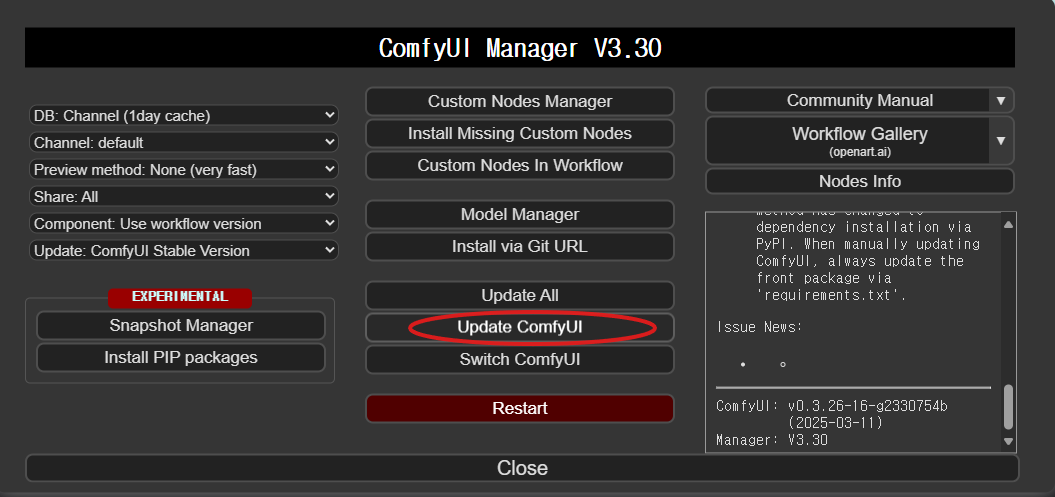

이번 포스팅에서는 별도로 다운로드해야 할 커스텀 노드 없이 진행됩니다. 하지만 ComfyUI를 최신 버전으로 업데이트하는 것이 중요합니다. 최신 버전으로 업데이트하면 모델과의 호환성을 극대화할 수 있으며, 성능 개선 및 버그 수정을 통해 최적의 결과를 얻을 수 있습니다.

- Stability Matrix를 사용하는 경우 → Stability Matrix 화면에서 "Update" 버튼을 클릭하여 간편하게 업데이트할 수 있습니다.

- ComfyUI를 로컬에 설치한 경우 → ComfyUI-Manager에서 "Update ComfyUI" 버튼을 눌러 최신 버전으로 업데이트하세요.

3. Wan2.2-S2V 모델

Wan2.2-S2V 모델을 사용하여 로컬에서 이미지 + 오디오 기반 영상 생성 과정에 대해 알아보겠습니다.

1) ComfyUI Workflow

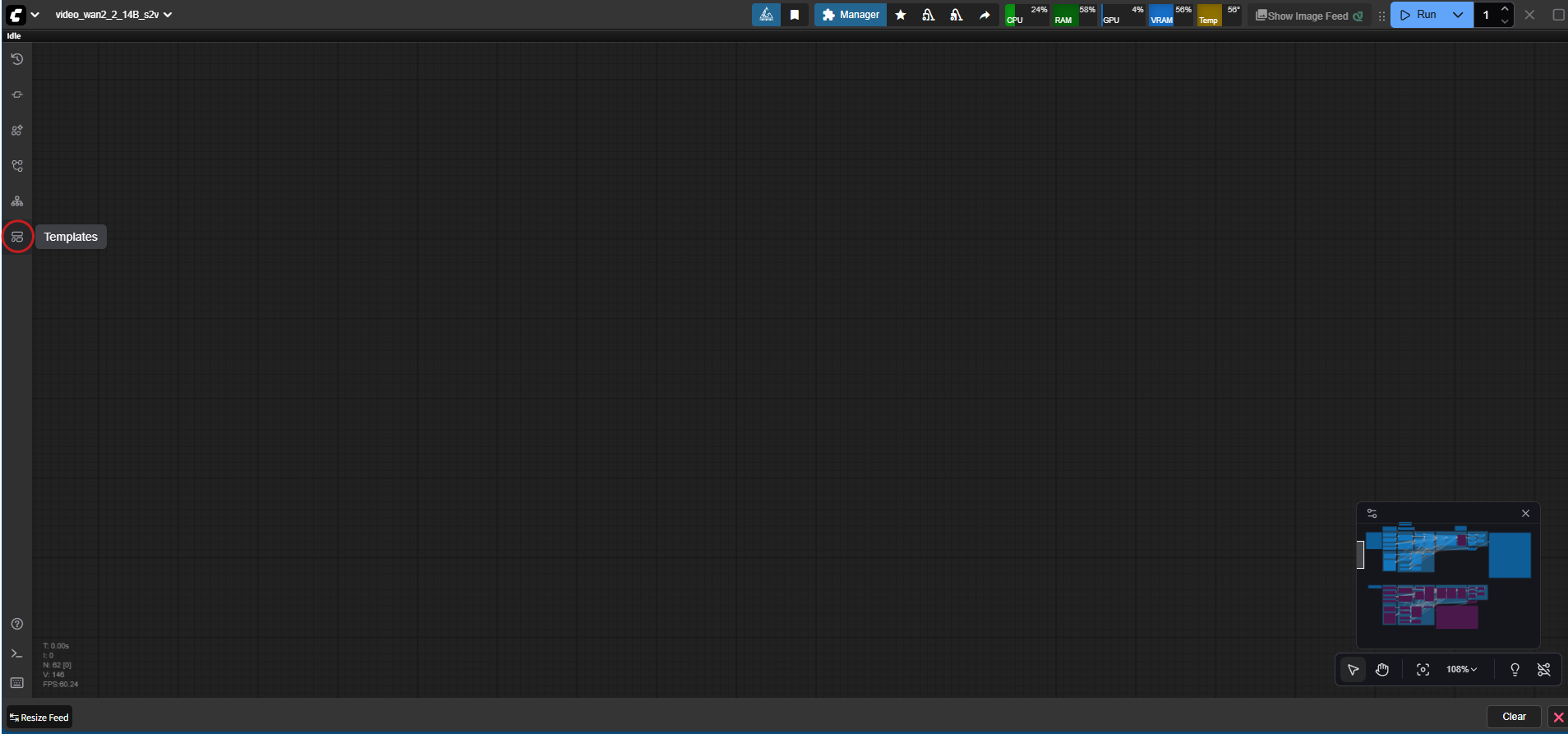

최신 ComfyUI에서는 웹 UI 내에서 워크플로우를 간편하게 불러올 수 있습니다.

- ComfyUI를 실행

- 왼쪽탭에서 "Templates" 버튼 클릭

- "Video" 항목에서 "Wan2.2-S2V Audio-Driven Video Generation" 버튼 클릭

2) 모델 파일 다운로드

ComfyUI에서 워크플로우 파일을 불러오면, 해당 모델을 자동으로 탐색하며, 로컬에 모델이 없는 경우 다운로드 링크를 안내해줍니다. 이 링크를 통해 손쉽게 필요한 모델 파일을 다운로드할 수 있습니다.

모델 다운로드가 완료되면, 아래와 같이 지정된 폴더 구조에 맞게 파일을 이동해 줍니다.

ComfyUI/

├───📂 models/

│ ├───📂 diffusion_models/

│ │ ├─── wan2.2_s2v_14B_fp8_scaled.safetensors

│ │ └─── wan2.2_s2v_14B_bf16.safetensors

│ ├───📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors

│ ├───📂 audio_encoders/ # Create one if you can't find this folder

│ │ └─── wav2vec2_large_english_fp16.safetensors

│ ├───📂 vae/

│ │ └── wan_2.1_vae.safetensors

│ └── 📂 lora/ # (선택사항 - 20스텝 → 4스텝 단축)

│ └─── wan2.2_t2v_lightx2v_4steps_lora_v1.1_high_noise.safetensors

모든 모델 파일을 다운로드하셨다면, 위와 같은 폴더 구조에 맞춰 각 파일을 옮겨줍니다. 만약 StabilityMatrix를 통해 ComfyUI를 실행 중이라면, [StabilityMatrix → Data → Packages] 경로 내부에서 ComfyUI 폴더 위치를 먼저 확인한 후, 동일하게 위 폴더 구조로 파일을 배치하시면 됩니다.

3) 실행 (영상 생성)

Wan2.2-S2V 모델을 활용하여 정적 이미지와 오디오 데이터를 입력하고, 프롬프트를 통해 원하는 장면을 구체적으로 묘사하여 영상을 생성했습니다. 이를 통해 단순한 이미지 변환이 아닌, 오디오 리듬과 감정이 반영된 자연스러운 장면을 만들 수 있었습니다.

아래는 영상 생성에 실제로 사용한 이미지, 오디오, 그리고 프롬프트 예시입니다.

[입력 프롬프트]

The man is playing the guitar. He looks down at his hands playing the guitar and sings affectionately and gently.

[입력 이미지]

[입력 오디오]

Wan2.2-S2V 모델을 활용해 영상을 생성한 결과, 약 14.2GB의 VRAM을 사용했으며 총 소요 시간은 약 12분이었습니다. 전체 과정은 안정적으로 진행되었고, 입력한 이미지·오디오·프롬프트가 자연스럽게 결합된 결과물을 확인할 수 있었습니다.

세부적으로 살펴보면, 손가락 움직임과 같은 세밀한 손 표현에서는 픽셀이 다소 깨져 보이는 현상이 나타났습니다. 그러나 입 모양은 첫 시작 부분을 제외하고는 오디오와 자연스럽게 동기화되었으며, 감정 표현도 부드럽게 잘 구현되었습니다. 이러한 결과를 종합하면, Wan2.2-S2V는 여전히 세밀한 디테일에서 개선 여지가 남아 있지만, 자연스러운 입술 동기화와 안정적인 영상 생성 성능 측면에서 충분히 활용 가치가 높은 모델임을 확인할 수 있습니다.

[생성 결과]

알리바바에서 공개한 Wan2.2-S2V 모델은 기존의 이미지·텍스트 기반 영상 생성에서 한 단계 발전하여, 오디오까지 활용한 더욱 몰입감 있는 결과물을 만들어낼 수 있습니다. 손가락 움직임 등 일부 세부 표현에서는 여전히 개선이 필요하지만, 입 모양 동기화와 전반적인 장면의 자연스러움은 매우 우수한 수준을 보여주었습니다.

앞으로 LoRA 적용, 프롬프트 최적화, 스텝 수 조정 등을 통해 품질을 한층 더 높일 수 있으며, 실제 프로젝트나 콘텐츠 제작 워크플로우에 적용하기에도 충분히 실용적인 모델로 평가됩니다. 영상 생성 AI를 활용해 보고자 한다면 Wan2.2-S2V는 훌륭한 출발점이 될 것입니다.

감사합니다. 😊