안녕하세요.

구글이 최근 공개한 Gemma 3 시리즈는 다양한 크기와 성능을 갖춘 언어 모델 가운데, 특히 초소형 버전인 Gemma 3 270M이 눈길을 끌고 있습니다. 이 모델은 크기가 1GB도 되지 않을 만큼 가볍고 효율적으로 설계되어, 로컬 환경이나 자원이 제한된 기기에서도 손쉽게 실행할 수 있다는 점에서 큰 장점을 가지고 있습니다.

이번 글에서는 Gemma 3 270M 모델의 소개와 주요 특징, 그리고 직접 로컬 환경에서 실행해보는 방법까지 차례대로 살펴보겠습니다.

Gemma 3 270M 모델이란

2025년 8월 14일, 구글은 크기는 작지만 효율적이며 강력한 instruction-following 능력을 갖춘 모델인 Gemma 3 270M을 공개했습니다. 이 모델은 Gemma 시리즈에 새롭게 추가된 버전으로, 2억 7천만 개의 매개변수를 지닌 소형 AI 모델입니다. 특정 작업에 맞춘 정교한 파인튜닝에 최적화되어 있으며, 이미 학습된 instruction 튜닝과 텍스트 구조화 능력을 바탕으로 다양한 활용이 가능합니다. Gemma 3, Gemma 3 QAT, Gemma 3n 등과 함께 발전해 온 Gemma 시리즈 중 하나로, 경량화된 형태임에도 성능과 효율성을 균형 있게 갖춘 모델로 평가됩니다.

[모델 정보 요약]

| 항목 | 내용 |

| 모델명 | Gemma 3 270M |

| 파라미터 수 | 270M (2억 7천만) |

| 개발사 | |

| 출시일 | 2025년 8월 14일 (현지 시간) |

| 컨텍스트 길이 | 최대 32K 토큰 입력 및 출력 |

| 특징 | 가볍고 효율적인 구조, 온디바이스 모델 |

| 라이선스 | “Gemma” 사용 약관 기반 라이선스 |

주요 특징

- 컴팩트한 구조와 대규모 어휘 : 총 270M 파라미터로 구성되어 있지만, 256k 토큰이라는 매우 큰 어휘(vocabulary)를 가지고 있습니다. 덕분에 희귀하거나 전문적인 단어도 잘 처리하여 파인튜닝 시 높은 성능을 기대할 수 있습니다.

- 압도적인 전력 효율성 : Pixel 9 Pro 기기에서 INT4 양자화 모델로 25개의 대화를 처리하는 데 배터리를 단 0.75%만 사용할 정도로 전력 소모가 매우 적습니다.

- 즉시 사용 가능한 명령어 수행 능력 : 사전 학습된 모델 외에 명령어 튜닝(instruction-tuned)된 모델도 함께 제공되어, 복잡한 대화는 아니더라도 일반적인 지시를 바로 이해하고 수행할 수 있습니다.

- 온디바이스(On-device)에 최적화된 양자화 : QAT(양자화 인지 학습) 기술이 적용되어, 모델을 INT4 정밀도로 압축해도 성능 저하가 거의 없습니다. 이는 모바일 기기나 엣지 장치처럼 자원이 제한된 환경에 배포하기에 매우 유리합니다.

벤치마크 성능

Gemma 3 시리즈의 성능은 모델 크기와 학습 방식(PT/IT)에 따라 달라집니다.

- PT 모델(Pretrained)은 방대한 텍스트 데이터를 학습한 기본형 모델로, 언어 이해와 지식 기반 질의응답에서 강점을 보입니다. 모델의 크기가 커질수록 정확성과 추론 능력이 크게 향상됩니다.

- IT 모델(Instruction-Tuned)은 PT 모델을 바탕으로 지시문과 정답 데이터를 추가 학습한 버전으로, 사용자의 요청을 이해하고 응답하는 데 최적화되어 있습니다. 특히 IFEval과 같은 지시문 수행 평가에서 PT 모델보다 월등히 높은 성능을 기록합니다.

정리하면, PT 모델은 지식과 언어 이해 중심의 기본형, IT 모델은 지시문 수행과 대화 중심의 실사용형이라는 차이가 있습니다.

[Gemma 3 PT 모델 비교]

| Benchmark | n-shot | Gemma 3 PT 270M |

Gemma 3 PT 1B |

Gemma 3 PT 4B |

Gemma 3 PT 12B |

Gemma 3 PT 27B |

| HellaSwag | 10-shot | 40.9 | 62.3 | 77.2 | 84.2 | 85.6 |

| BoolQ | 0-shot | 61.4 | 63.2 | 72.3 | 78.8 | 82.4 |

| PIQA | 0-shot | 67.7 | 73.8 | 79.6 | 81.8 | 83.3 |

| TriviaQA | 5-shot | 15.4 | 39.8 | 65.8 | 78.2 | 85.5 |

| ARC-c | 25-shot | 29.0 | 38.4 | 56.2 | 68.9 | 70.6 |

| ARC-e | 0-shot | 57.7 | 73.0 | 82.4 | 88.3 | 89.0 |

| WinoGrande | 5-shot | 52.0 | 58.2 | 64.7 | 74.3 | 78.8 |

| BIG-Bench Hard | – | – | 28.4 | 50.9 | 72.6 | 77.7 |

[벤치마크 의미]

- HellaSwag : 상식적 추론과 문맥 이해 능력

- BoolQ : 질문에 대해 참·거짓을 정확히 판별하는 능력

- PIQA : 물리적 상식과 일상적 상황 판단 능력

- TriviaQA : 사실 기반의 지식 검색 및 응답 능력

- ARC-c : 과학적 개념이 포함된 복잡한 문제 해결 능력

- ARC-e : 기본 과학 지식을 활용한 문제 해결 능력

- WinoGrande : 대명사와 문맥을 올바르게 해석하는 능력

[Gemma 3 IT 모델 비교]

| Benchmark | n-shot | Gemma 3 IT 270M |

Gemma 3 IT 1B |

Gemma 3 IT 4B |

Gemma 3 IT 12B |

Gemma 3 IT 27B |

| BIG-Bench Hard | few | 26.7 | 39.1 | 72.2 | 85.7 | 87.6 |

| IFEval | 0-shot | 51.2 | 80.2 | 90.2 | 88.9 | 90.4 |

[벤치마크 의미]

- BIG-Bench Hard : 난도가 높은 추론 및 복합적 사고 능력

- IFEval : 사용자의 지시문을 올바르게 이해하고 수행하는 능력

종합 평가

Gemma 3 270M 모델은 가장 작은 규모의 모델이지만, 여러 벤치마크에서 모델 크기에 비해 놀라울 만큼 높은 점수를 기록하고 있습니다. BoolQ(61.4), PIQA(67.7), WinoGrande(52.0)와 같은 평가에서 특히 준수한 성능을 보여주며, 이는 270M 파라미터라는 제한된 크기를 고려했을 때 상당히 인상적인 결과입니다.

물론, 1B 이상 모델과 비교하면 성능 격차가 분명하게 나타나지만, 저비용·저자원 환경에서도 활용 가능한 경량 모델로서의 가치는 확실합니다. Instruction-Tuned(IT) 버전 역시 IFEval에서 51.2를 기록하며, 단순한 응답을 넘어 지시문 수행 능력에서도 의미 있는 성능을 보여줍니다.

정리하면, Gemma 3 270M은 소형 모델 중에서도 효율성과 성능의 균형을 잘 갖춘 모델로, 대형 모델 대비 성능은 낮더라도 그 크기와 효율성을 고려하면 충분히 경쟁력 있는 선택지라고 할 수 있습니다.

라이선스

Gemma 3 270M 모델은 Gemma 라이선스를 따르고 있습니다. 이 라이선스는 상업적 활용이 허용된 오픈 모델로, 사용자는 모델을 직접 다운로드하여 연구나 비즈니스 목적으로 자유롭게 이용할 수 있습니다. 다만, 모델을 배포하거나 파생 모델을 공유할 경우 반드시 라이선스 조건을 명시해야 하며, 불법적이거나 유해한 용도로는 사용할 수 없습니다. 또한 Google은 라이선스 위반이나 문제가 발생할 경우 모델 사용을 제한할 권리를 보유하고 있습니다.

자세한 내용은 아래 Gemma 라이선스를 참고해주시기 바랍니다.

Gemma 라이선스 : https://ai.google.dev/gemma/terms

Gemma 3 270M 모델 사용하기

Gemma 3 270M 모델은 크기가 작은 모델이어서 로컬 환경이나 클라우드, 심지어 자원이 제한된 기기에서도 활용할 수 있습니다. Hugging Face나 Kaggle 같은 플랫폼을 통해 바로 실행할 수 있으며, 직접 코드를 작성해 맞춤형으로 활용하는 것도 가능합니다.

이번 글에서는 Ollama를 이용한 간편 실행 방법과 직접 코드를 작성해 실행하는 방법을 소개하겠습니다.

1. Ollama를 이용한 간편 실행 방법

1) 사전 준비 사항

먼저, Gemma 3 270M 모델을 로컬 환경에서 실행하기 위해 Ollama를 활용하는 방법을 소개합니다. Ollama는 모델을 양자화(Quantization)된 형태로 제공하기 때문에, 상대적으로 적은 리소스로도 효율적으로 실행할 수 있어 경량 모델인 Gemma 3 270M과 잘 어울립니다. 따라서 복잡한 설정 없이 로컬 환경에서도 실용적으로 사용할 수 있습니다.

Ollama 설치 : https://ollama.com/download

2) 실행 환경

- 운영체제 : Windows 11

- ollama : 0.11.4

- GPU : NVIDIA GeForce RTX 4060 Ti (VRAM 16 GB)

3) Gemma 3 270M 다운로드 및 실행

Ollama 설치가 완료되었다면 프로그램을 실행합니다. 프롬프트 창에서 모델 선택 버튼을 눌러 "gemma3:270m" 모델을 선택할 수 있습니다.

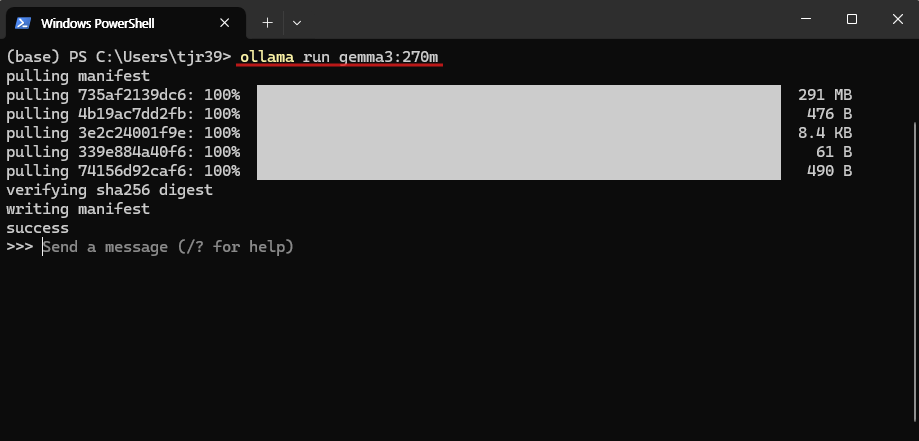

만약 목록에 해당 모델이 보이지 않는 경우, Windows PowerShell에서 아래 명령어를 입력해 수동으로 다운로드하면 됩니다. 다운로드가 완료되면 모델이 정상적으로 표시되어 실행할 수 있습니다.

# Windows PowerShell

ollama run gemma3:270m # gemma 3 270m 모델 다운로드 및 실행

[실행 결과]

모델은 VRAM을 2GB 미만으로 사용하며, 간단한 문장에 대해서는 1초 이내로 빠른 응답을 제공합니다. 다만 답변의 길이가 짧게 생성되고, 때때로 엉뚱한 응답을 내놓기도 합니다. 예를 들어, 수학 공식으로 잘 알려진 피타고라스의 정리를 물었을 때, 전혀 관련 없는 “피타고스의 유산”이라는 에세이를 설명하는 답변을 했습니다. (아래 예시 이미지 참조) 이는 전형적인 할루시네이션 현상으로 보입니다.

따라서 이 모델은 빠른 응답 속도와 낮은 GPU 자원 사용이 필요한 온디바이스 환경에는 적합하지만, 높은 정확도가 요구되는 작업에는 사용을 피하는 것이 바람직합니다.

2. 직접 코드 작성 및 실행

1) 사전 준비 사항

이번 포스팅에서는 gemma-3-270m-it 버전을 활용하여 실행 과정을 살펴보겠습니다. 해당 모델을 직접 코드로 실행하려면 Python 환경이 필요하므로, 먼저 로컬 환경에 맞는 버전의 Python을 설치해야 합니다. 그리고 구글 허깅페이스에서 제공하는 gemma-3-270m-it 모델을 다운로드합니다.

Python 설치 : https://www.python.org/downloads/

구글 허깅페이스 gemma 3 270 it 모델 다운로드 : https://huggingface.co/google/gemma-3-270m-it

2) 실행 환경

- 운영체제 : Windows 11

- Python : 3.10.0

- GPU : NVIDIA GeForce RTX 4060 Ti (VRAM 16 GB)

3) 패키지 설치

gemma-3-270m-it 모델을 실행하기 위해 필요한 패키지를 설치합니다. 아래 명령어를 Windows PowerShell에서 실행하면 됩니다.

# Windows PowerShell

pip install transformers accelerate

pip install torch==2.6.0 --index-url https://download.pytorch.org/whl/cu126

4) 코드 작성

아래와 같이 gemma-3-270m-it 모델과 간단한 문답을 주고받을 수 있는 코드를 작성합니다.

# Python

import os

os.environ["TORCH_COMPILE_DISABLE"] = "1" # Inductor/Triton 경로 비활성화(즉시모드로 실행)

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

try:

torch.set_float32_matmul_precision("high")

except Exception:

pass

model_id = r"Path/to/gemma3/gemma-3-270m-it" # 사용자 환경에 맞게 수정

tokenizer = AutoTokenizer.from_pretrained(model_id, use_fast=True)

if tokenizer.pad_token is None:

tokenizer.pad_token = tokenizer.eos_token

model = AutoModelForCausalLM.from_pretrained(model_id, device_map="auto")

def chat_once(user_text: str, max_new_tokens: int = 128) -> str:

messages = [

{"role": "system", "content": "당신은 간결하고 친절하게 답변하는 한국어 비서입니다."},

{"role": "user", "content": user_text},

]

inputs = tokenizer.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=True,

return_tensors="pt",

return_dict=True,

padding=True

)

inputs = {k: v.to(model.device) for k, v in inputs.items()}

with torch.no_grad():

out_ids = model.generate(

input_ids=inputs["input_ids"],

attention_mask=inputs["attention_mask"],

max_new_tokens=max_new_tokens,

do_sample=True,

temperature=0.7,

top_p=0.9,

pad_token_id=tokenizer.eos_token_id,

eos_token_id=tokenizer.eos_token_id,

)

full = tokenizer.decode(out_ids[0], skip_special_tokens=True)

prompt = tokenizer.decode(inputs["input_ids"][0], skip_special_tokens=True)

reply = full.replace(prompt, "").strip()

if not reply:

reply = full[len(prompt):].strip()

return reply

if __name__ == "__main__":

print("gemma-3-270m-it 간단 테스트를 시작합니다. 종료하려면 'exit'를 입력합니다.")

while True:

q = input("\n질문: ").strip()

if q.lower() == "exit":

print("종료합니다.")

break

try:

print("\n[답변]\n" + chat_once(q))

except Exception as e:

print(f"[오류] {e}")

[실행 결과]

이번 방식에서는 모델이 약 2.4GB의 VRAM을 사용했으며, 답변을 생성하는 데 8~10초 정도가 소요되었습니다. 간단한 질문에는 비교적 빠르게 응답했지만, 전문적인 내용을 묻는 경우 할루시네이션 현상이 발생했습니다. Ollama 실행에서 사용한 프롬프트와 동일하게 두 가지 질문을 진행했는데, 피타고라스 정리에 대한 질문에서는 전혀 관련 없는 답변을 내놓았습니다.

이번 글에서는 Gemma 3 270M 모델의 특징과 개요를 살펴보고, 이어서 로컬 환경에서 직접 실행하는 방법을 단계별로 정리했습니다. Gemma 3 270M은 크기는 작지만 빠른 응답 속도와 낮은 자원 사용량 덕분에, 온디바이스 환경이나 가벼운 실험·연구 목적에 적합한 모델입니다. 물론 전문적인 작업에서는 한계가 분명하지만, 학습용이나 프로토타이핑 관점에서 충분히 가치 있는 선택지가 될 수 있습니다. 앞으로도 상위 모델과의 조합이나 다양한 튜닝을 통해 활용 범위를 넓힐 수 있을 것으로 기대됩니다.

감사합니다. 😊

'AI 소식 > 오픈소스 AI 모델' 카테고리의 다른 글

| [오픈소스 AI] 중국 Z.ai의 최신 V-LLM, GLM-4.5V를 소개합니다. (4) | 2025.08.21 |

|---|---|

| [오픈소스 AI] LFM2-VL 모델 소개 | 온디바이스 최적화 멀티모달 비전-언어 모델 (1) | 2025.08.20 |

| [오픈소스 AI] 중국 MetaStone AI의 XBai-o4 공개 – 성능, 특징, 벤치마크 완전 분석 (4) | 2025.08.15 |

| 중국 텐센트 LLM ‘Hunyuan-A13B-Instruct’ 소개 | 오픈소스 AI | (6) | 2025.08.14 |

| [오픈소스 AI] 엔비디아 무료 추론 AI 모델, OpenReasoning-Nemotron(Qwen2.5 기반) 소개 및 로컬 실행 가이드 (3) | 2025.08.12 |