안녕하세요,

최근, 낮은 VRAM 환경에서도 고품질의 영상을 생성할 수 있는 AI 모델이 등장하였습니다. 기존의 영상 생성 모델들은 연산량과 메모리 사용량이 비례하여, 긴 영상을 생성하려면 고사양 GPU가 필수적이었습니다. 하지만 새롭게 발표된 이번 영상 생성 모델은 이러한 한계를 극복하며, 일반적인 사양의 GPU에서도 놀라운 품질의 영상을 제작할 수 있도록 지원합니다. 이번 글에서는 이 모델의 원리와 주요 특징을 살펴보고, 설치 및 사용방법에 대해 알아보겠습니다.

FramePack 이란

FramePack은 스탠포드 대학교에서 개발한 차세대 비디오 생성 모델로, 입력 프레임을 압축해 고정된 길이로 유지함으로써 비디오 생성의 효율성과 품질을 동시에 향상시킵니다. 특히 이미지 기반 비디오 생성(image-to-video) 분야에서 뛰어난 성능을 발휘하며, 낮은 VRAM 환경에서도 장시간 고품질 영상을 안정적으로 생성할 수 있도록 설계되었습니다.

- FramePack 프로젝트 페이지 : https://lllyasviel.github.io/frame_pack_gitpage/

FramePack

All results are computed by RTX 3060 laptop 6GB with 13B HY variant. (Videos compressed by h264crf18 to fit in GitHub repos.)

lllyasviel.github.io

이 모델은 다음 프레임 예측(next-frame prediction) 방식을 기반으로, 입력 프레임의 컨텍스트를 일정한 길이로 압축하여 비디오 길이에 관계없이 일정한 연산량을 유지합니다. 이러한 구조 덕분에 기존 모델들이 겪던 VRAM 사용량 증가 문제를 해결하고, 노트북 GPU처럼 성능이 제한된 환경에서도 고해상도 비디오 생성이 가능합니다. 실제로 FramePack을 활용하면 약 2분 분량의 영상도 무리 없이 제작할 수 있습니다.

주요 특징

- 고정된 입력 컨텍스트 길이 : 비디오 길이에 상관없이 일정한 연산량을 유지 → VRAM 사용량을 일정하게 유지

- 프레임 중요도 기반 압축 : 예측 대상에 가까운 프레임일수록 더 많은 GPU 자원을 할당 → 더 정밀한 처리 가능

- 다양한 압축 스케줄링 지원 : 프레임별 중요도에 따라 압축 비율 조절 가능 → 자원 분배 전략 유연

- Anti-Drifting Sampling : 드리프트(누적 오류) 현상 방지를 위해 양방향 샘플링 적용 → 비디오 품질 안정성 향상

- 낮은 VRAM 요구사항 : 13B 모델 기준, 6GB VRAM에서도 30fps 비디오 생성 가능 → 저사양 장치에서도 실행 가능

라이선스

FramePack은 Apache License 2.0 하에 배포되며, 상업적 이용을 포함한 자유로운 사용, 수정, 배포가 가능합니다. 단, 소프트웨어를 사용할 때는 라이선스 전문에 명시된 조건을 따라야 하며, 저작권 및 라이선스 고지를 유지해야 합니다. 이로 인해 연구 목적뿐만 아니라 상업적인 프로젝트에도 유연하게 적용할 수 있는 장점이 있습니다.

사전준비사항

이 포스팅은 ComfyUI에서 FramePack 모델을 활용하는 방법에 대한 내용입니다. 본문을 읽기 전에 아래 항목들을 미리 설치해 주시기 바랍니다.

[Stabiliy Matrix&ComfyUI 설치하기] (포스팅에서 사용한 방식)

- ComfyUI 설치: [Marcus' Story] - [ComfyUI] 초보자도 쉽게 따라하는 Stability Matrix 활용하기

- ComfyUI-Manager 설치: [Marcus' Story] - [ComfyUI] Stability Matrix에 ComfyUI-Manager 설치하기

[로컬에 직접 ComfyUI 설치하기]

- ComfyUI 설치: [Marcus' Story] - [ComfyUI] [로컬 환경] ComfyUI 로컬 환경에 설치 및 실행 방법

- ComfyUI-Manager 설치: [Marcus' Story] - [ComfyUI] [로컬 환경] ComfyUI 관리 도구, ComfyUI-Manager 설치하기

목차

1. 실행 환경

2. ComfyUI 사용 노드

3. 다운로드 및 위치 설정

4. 영상 생성 (FramePack 활용)

1. 실행 환경

- 운영체제 : Windows 11

- ComfyUI : 0.3.30

- ComfyUI-Manager : V3.30

- Python : 3.10.11

- torch : 2.7.0 + cu128

- GPU : NVIDIA GeForce RTX 4060 Ti

2. ComfyUI 사용 노드

이번 포스팅에서 사용하는 ComfyUI 커스텀 노드는 다음과 같습니다. 해당 노드는 현재 데모 버전이기 때문에, ComfyUI 내부에서 자동으로 설치하려면 보안 수준 설정을 조정해야 합니다. 이번 글에서는 GitHub에서 직접 다운로드하여 설치하는 방식으로 진행하겠습니다.

- ComfyUI-FramePackWrapper [필수] : FramePack 모델을 ComfyUI에서 사용할 수 있도록 구현된 커스텀 노드입니다.

[설치방법]

1) 아래 깃허브 페이지에서 커스텀 노드를 다운로드합니다.

- ComfyUI-FramePackWrapper 깃허브 페이지 : https://github.com/kijai/ComfyUI-FramePackWrapper?tab=readme-ov-file

2) 다운로드한 파일의 압축을 아래 경로에 해제합니다.

- 경로 : StabilityMatrix → Data → Packages → ComfyUI → custom_nodes

3) 아래 명령어를 사용해 필요한 패키지를 설치합니다.

# Windows PowerShell

cd G:\StabilityMatrix\Data\Packages\ComfyUI\custom_nodes\ComfyUI-FramePackWrapper # 깃허브에서 다운로드한 경로로 설정

pip install requirements.txt # 필요 패키지 설치

3. 다운로드 및 위치 설정

FramePack 모델은 현재 허깅페이스에서 fp8 버전과 bf16 버전 두 가지로 제공되며, 사용자의 환경이나 목적에 맞게 선택하여 설치하시면 됩니다. 이 포스팅에서는 FramePackI2V_HY_fp8_e4m3fn 버전을 사용하였습니다.

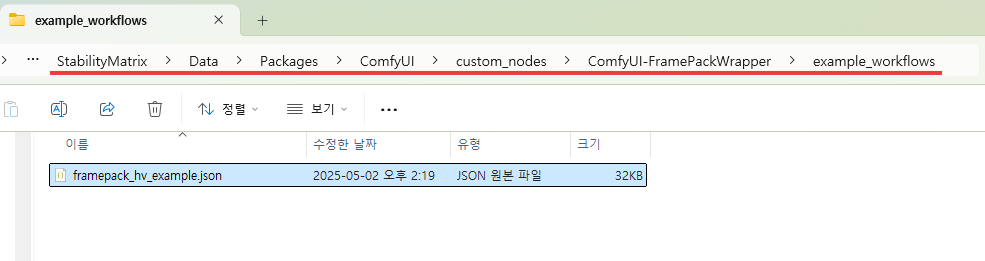

1) ComfyUI Workflow

앞서 다운로드한 ComfyUI-FramePackWrapper 커스텀 노드 폴더 내에 포함된 워크플로우 파일 (framepack_hv_example.json)을 사용하시면 됩니다. 해당 파일을 ComfyUI 실행 창에 드래그 앤 드롭하면 자동으로 워크플로우가 불러와져 바로 실행할 수 있습니다.

2) 모델 파일 다운로드

아래 허깅페이스 링크에서 모델 파일을 다운로드합니다. FramePack 모델은 fp8 버전과 bf16 버전 두 가지로 제공되며, 사용자의 환경에 맞는 버전을 선택해 다운로드하시면 됩니다.

| 모델 종류 | 파일명 | 허깅페이스 주소 |

| diffusion 모델 (영상 생성 모델) |

FramePackI2V_HY_fp8_e4m3fn.safetensors |

https://huggingface.co/Kijai/HunyuanVideo_comfy/tree/main |

| text_encoder 모델 |

1) clip_l_hidream.safetensors 2) llava_llama3_fp16.safetensors |

https://huggingface.co/Comfy-Org/HunyuanVideo_repackaged/tree/main/split_files/text_encoders |

| clip_vision 모델 | sigclip_vision_patch14_384.safetensors | https://huggingface.co/Comfy-Org/sigclip_vision_384/tree/main |

| vae 모델 | hunyuan_video_vae_bf16.safetensors | https://huggingface.co/Comfy-Org/HunyuanVideo_repackaged/tree/main/split_files/vae |

3) 모델 위치 이동

위 모델 파일을 모두 다운로드하셨으면, 각 모델을 아래 폴더로 이동시켜줍니다.

- diffusion 모델 : StabilityMatrix → Data → Packages → ComfyUI → models → diffusion_models

- text_encoder 모델 : StabilityMatrix → Data → Packages → ComfyUI → models → text_encoders

- clip_vision 모델 : StabilityMatrix → Data → Packages → ComfyUI → models → clip_vision

- vae 모델 : StabilityMatrix → Data → Packages → ComfyUI → models → vae

StabilityMatrix를 사용하지 않고 로컬에 ComfyUI를 직접 설치하신 경우에는, [StabilityMatrix → Data → Packages] 경로는 생략하시고, 바로 ComfyUI 폴더 내의 모델 디렉토리로 이동하시면 됩니다.

4. 영상 생성 (FramePack 활용)

지금까지의 설정이 완료되었다면, 영상 생성 준비는 끝났습니다. 이 워크플로우는 이미지 to 비디오 생성 방식으로 영상을 생성해줍니다. 아래 이미지와 프롬프트를 사용하여 4초 정도의 영상을 생성했습니다.

- 사용 프롬프트 : A fluffy golden puppy sitting on a dark stage under a spotlight, gently wagging its tail and blinking slowly, the name tag 'Marcus' swaying slightly on its collar, warm ambient lighting, subtle camera dolly-in movement, photorealistic, seamless animation loop, 4K

[생성 영상]

입력한 이미지는 512 x 512 픽셀 크기였으며, 생성된 영상은 608 x 640 픽셀 해상도, 약 4초 분량으로 출력되었습니다. 이 과정을 실행하는 데 약 15GB의 VRAM이 사용되었고, 약 20분의 시간이 소요되었습니다. 다소 시간이 오래 걸리긴 했지만, 생성된 영상은 매우 자연스럽고 퀄리티 또한 높았습니다.

이 모델이 특히 인상적인 점은, 이보다 더 긴 영상도 무리 없이 생성할 수 있다는 것입니다. 기존의 다른 영상 생성 모델들은 영상 길이가 길어질수록 필요한 VRAM이 급격히 증가하거나, 아예 생성이 되지 않는 경우도 종종 발생했습니다. 반면, FramePack은 상대적으로 낮은 VRAM 환경에서도 원하는 길이의 영상을 자유롭게 생성할 수 있다는 점에서 매우 강력한 장점을 가지고 있습니다.

이번 글에서는 낮은 VRAM 환경에서도 고품질 영상 생성이 가능한 FramePack 모델에 대해 살펴보았습니다. FramePack은 기존 영상 생성 모델들의 한계를 뛰어넘는 효율성과 확장성을 보여주며, 특히 일반 사용자나 제한된 환경에서도 영상 AI 기술을 활용하고자 하는 분들에게 매우 유용한 선택지가 될 수 있습니다. 아직은 데모 버전이고 최적화나 속도 면에서 개선의 여지가 있지만, 충분히 실험해볼 만한 가치가 있는 강력한 프레임워크입니다.

앞으로 더욱 발전될 FramePack의 행보도 기대해보며, 직접 설치해보고 다양한 이미지를 영상으로 변환해보는 경험을 추천드립니다.

감사합니다. 😊