안녕하세요,

지난 포스팅에서 FLUX.1 AI 모델의 설치 및 사용 방법을 소개드렸습니다. 다만, Flux 모델은 120억 개의 매개변수를 가지고 있어 고사양 PC가 필요하며, 이미지 생성 시 높은 퀄리티를 제공하지만 실행 속도와 자원 소모가 상당히 큽니다. 그러나, 최근에 낮은 사양의 PC에서도 실행 가능한 FLUX.1 AI FP8 버전 체크포인트가 배포되었습니다. 이번 포스팅에서는 낮은 사양에서도 FLUX.1 AI FP8 버전을 설치하고 사용하는 방법을 안내드리겠습니다.

이 내용은 "FLUX.1 AI 활용하기" 시리즈의 연장선에 있는 포스팅으로, ComfyUI 설치나 추가적인 필요한 노드에 관한 정보는 이전 포스팅을 참고해 주세요.

FLUX.1 AI 모델 (FP8 & FP16 버전)

현재 이미지 생성 모델로 FLUX는 매우 주목받고 있으며, 다양한 버전이 개발되고 있습니다. 이번에 소개드릴 FLUX.1 AI FP8 버전 역시 이러한 발전 흐름 속에서 탄생한 모델입니다. 이 버전은 오리지널 FLUX.1 AI FP16 버전보다 이미지 퀄리티는 다소 낮을 수 있지만, 낮은 VRAM 환경에서도 원활하게 작동할 수 있도록 최적화되었습니다.

FLUX.1 AI FP16 버전은 고해상도 이미지 생성이나 복잡한 디테일을 요구할 때 매우 유리한 모델로, 더 높은 정밀도를 제공합니다. 하지만 이 모델은 상당한 메모리 용량을 필요로 하며, 일반적으로 최소 24GB 이상의 VRAM을 요구합니다.

반면, FLUX.1 AI FP8 버전은 메모리 사용량을 대폭 줄이고 성능을 최적화한 버전입니다. FP16에 비해 약간의 이미지 품질 저하가 있을 수 있지만, VRAM이 적은 장치(6GB~12GB)에서도 원활하게 작동할 수 있어, 제한된 리소스 환경에서도 매우 적합합니다. 이런 이유로 FP8 버전은 메모리 절약과 성능 최적화가 중요한 환경에서 더 많이 사용되고 있습니다.

추가적으로, FP8 버전은 FP16 버전과 달리 저사양 GPU에서도 사용 가능하여, 개인 사용자나 소규모 개발 환경에서도 효과적으로 사용할 수 있습니다. 이는 보다 많은 사용자들이 고성능 AI 이미지 생성 모델을 경험할 수 있게 해주는 장점이 있습니다. 다만, 복잡한 디테일이 필요한 작업에서는 FP16 버전이 더 적합할 수 있습니다.

목차

1. 실행 환경

2. 다운로드 모델 및 커스텀 노드

3. 노드 구성

4. 실행 (이미지 생성)

5. ComfyUI Vram 옵션

1. 실행 환경

- 운영체제 : Windows 11

- ComfyUI : 0.2.2

- ComfyUI-Manager : V2.51

- Python : 3.10.14

- torch : 2.4.1 + cu121

- GPU : NVIDIA GeForce RTX 4060 Ti

2. 다운로드 모델 및 커스텀 노드

1) ComfyUI 커스텀 노드

추가로 설치해야 할 필수 커스텀 노드는 없습니다. 하지만 ComfyUI를 더욱 편리하게 사용할 수 있는 노드들을 정리한 내용이 있습니다. 아래 링크를 참고해 주세요.

- Custom Node 설치 : [Marcus' Story] - ComfyUI 자주 사용하는 노드

2) 모델 파일 다운로드 및 디렉토리 설정

아래의 FLUX.1 AI 모델들을 다운받습니다.

- FLUX.1 AI (FP16) : https://huggingface.co/Comfy-Org/flux1-dev/tree/main

- FLUX.1 AI (FP8) : https://huggingface.co/Comfy-Org/flux1-schnell/tree/main

모델 파일을 다운로드가 완료되셨으면, 해당 파일을 아래 경로에 있는 checkpoints 폴더로 이동시켜 주세요.

(ComfyUI 폴더) → (models 폴더) → (checkpoints 폴더)

3. 노드 구성

1) FLUX.1-dev 노드 구성

FLUX.1-dev 모델을 사용하기 위한 노드 구성은 ComfyUI 제작자가 제공하는 깃허브 페이지에서 다운로드할 수 있습니다.

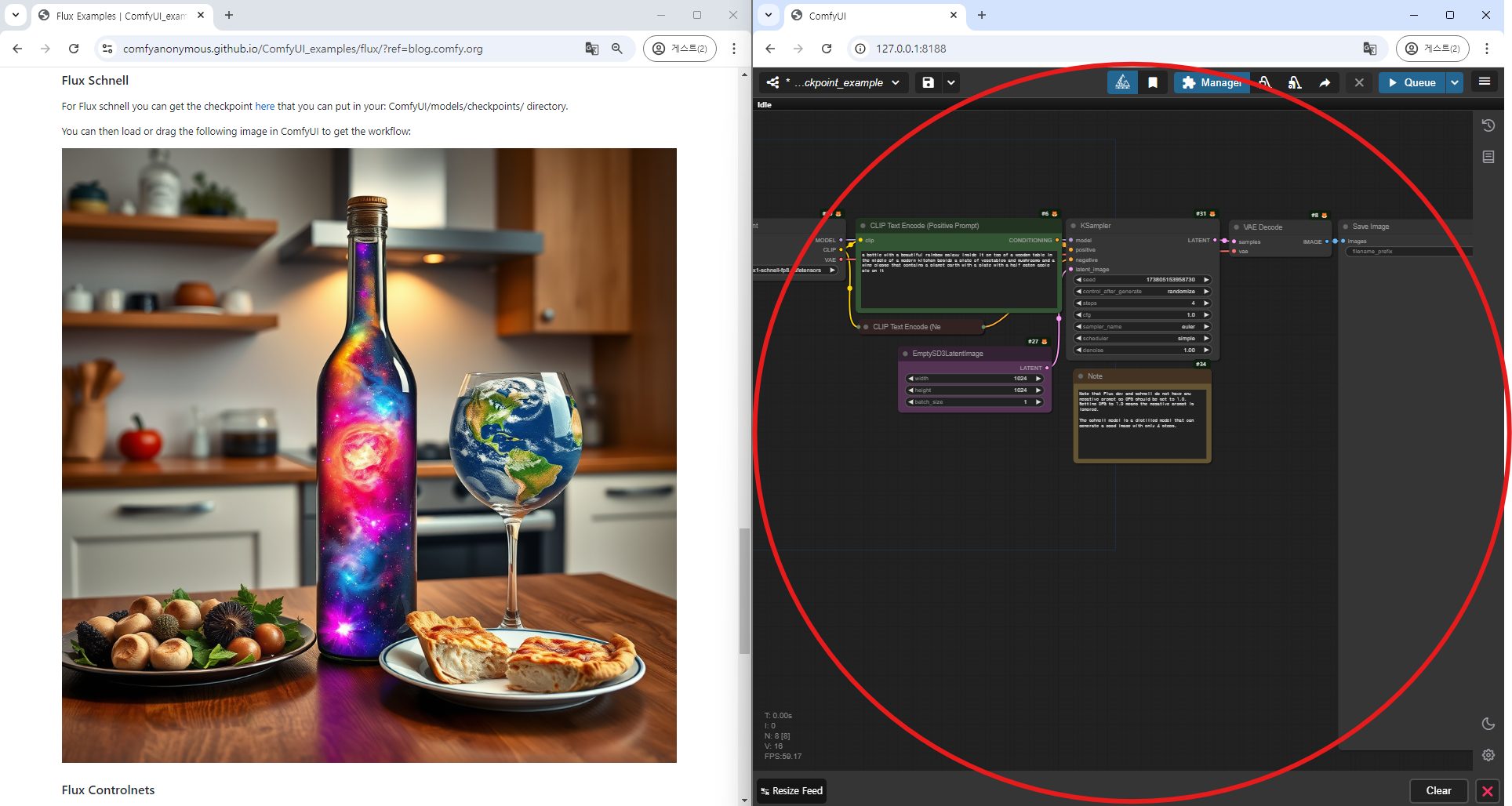

- ComfyUI FLUX Dev FP8 : https://comfyanonymous.github.io/ComfyUI_examples/flux/?ref=blog.comfy.org#simple-to-use-fp8-checkpoint-version

지난 포스팅에서 설명드린 바와 같이, 해당 페이지에서 제공하는 이미지를 마우스 왼쪽 버튼으로 클릭한 상태에서 실행 중인 ComfyUI 창으로 드래그하면, FLUX.1-dev FP8 모델을 실행하기 위한 노드들이 자동으로 구성됩니다.

1) FLUX.1-schnell 노드 구성

FLUX.1-schnell 모델을 위한 노드 구성도 위와 동일한 방법으로 설정할 수 있습니다. ComfyUI 제작자가 제공하는 깃허브 페이지에 접속 하신 후 해당 노드 구성을 다운로드받습니다.

- ComfyUI FLUX Schnell FP8 : https://comfyanonymous.github.io/ComfyUI_examples/flux/?ref=blog.comfy.org#flux-schnell-1

해당 페이지에서 제공하는 이미지를 마우스 왼쪽 버튼으로 클릭한 후, 실행 중인 ComfyUI 창으로 드래그하면 FLUX.1-Schnell FP8을 실행하기 위한 노드들이 자동으로 구성됩니다. FLUX.1-Schnell FP8 노드 구성은"FluxGuidance 노드"를 사용하지 않는다는 점만 FLUX.1-dev와 다르며, 나머지 노드는 동일하게 사용됩니다.

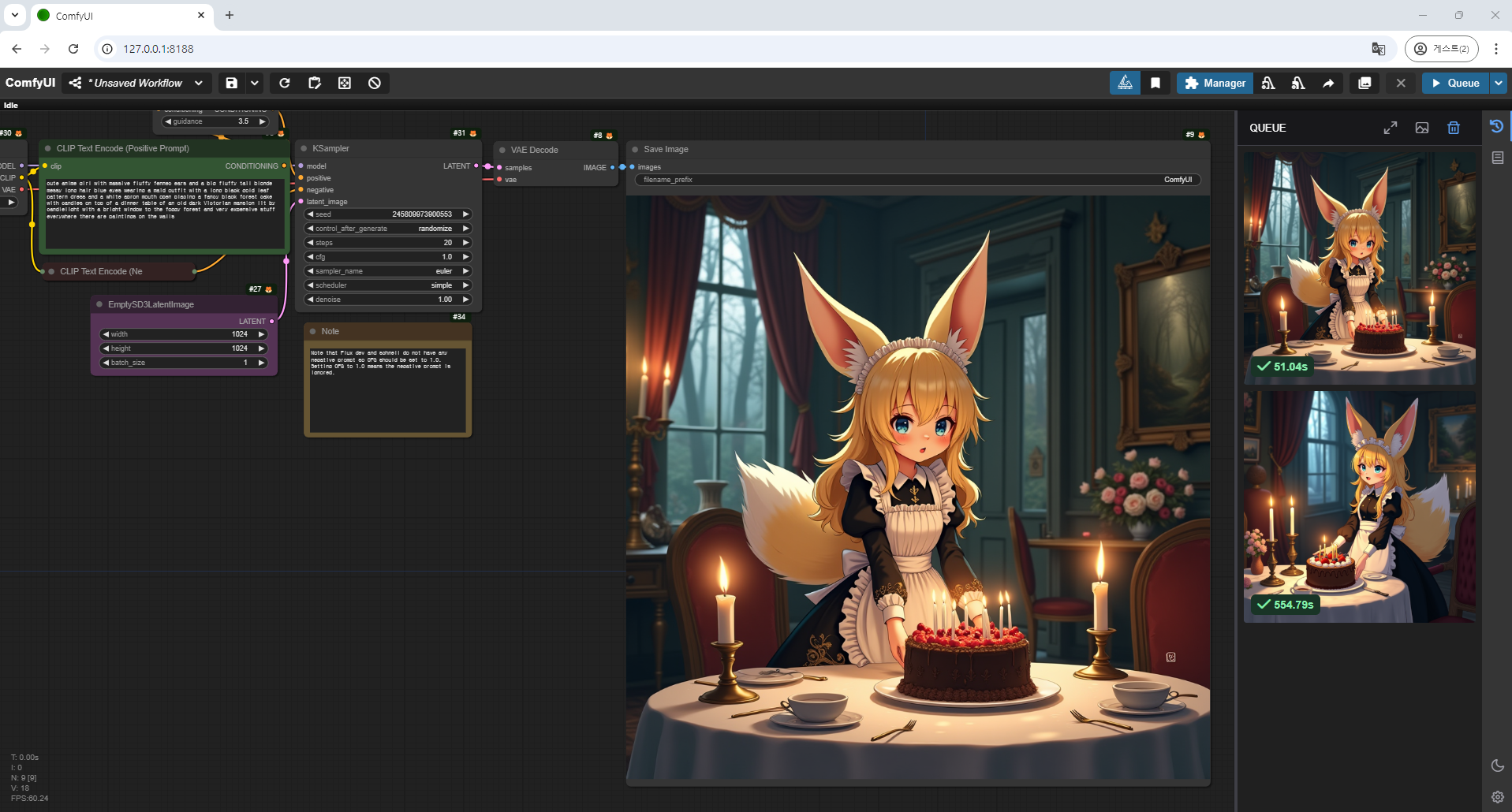

4. 실행 (이미지 생성)

준비한 모델과 노드 구성을 토대로 이미지를 생성해보겠습니다.

FLUX.1-Dev FP8 모델은 처음 로드할 때 약 9분 정도 소요되었으며, 이미지를 생성하는 데에는 약 50초가 걸렸습니다. 이는 이전에 사용했던 FP16 버전에 비해 상당히 빨라진 속도로, 실행 시간이 크게 단축되었습니다. 그럼에도 불구하고 이미지의 퀄리티는 눈에 띄는 차이가 없을 정도로 훌륭하며, FP8 버전임에도 만족스러운 결과를 얻을 수 있었습니다.

FLUX.1-Schnell FP8 모델은 더욱 빠른 속도로 이미지 생성이 가능합니다. 실제로 이미지를 생성하는 데 약 11초밖에 걸리지 않았고, 그럼에도 불구하고 매우 높은 품질의 이미지를 제공했습니다. FP8 버전은 VRAM 사용량을 줄이면서도 성능을 최적화한 덕분에, 특히 낮은 사양의 시스템에서도 빠르고 효율적인 이미지 생성을 할 수 있는 것이 큰 장점입니다.

추가적으로, 두 모델 모두 ComfyUI의 최적화 덕분에 설치 및 설정 과정이 간편했으며, FP8의 성능 최적화 덕분에 다중 이미지 생성 작업이나 빠른 프로토타이핑 작업에서도 매우 유용하다는 점이 돋보였습니다.

5. ComfyUI VRAM 옵션

ComfyUI가 0.2.2 버전으로 업데이트되면서 VRAM을 관리할 수 있는 새로운 기능이 추가되었습니다. 이 기능을 통해 ComfyUI를 실행할 때 일부 VRAM을 예약하여 여분의 공간을 남겨두는 방식으로 사용할 수 있습니다. 이를 활용하면 AI 모델을 사용 중에 발생할 수 있는 "Out of Memory" 에러를 방지할 수 있습니다. 특히, VRAM이 부족해 모델을 실행하지 못하던 경우에도 이 기능 덕분에 이제는 실행이 가능해졌습니다.

다만, VRAM을 의도적으로 남겨두면 VRAM이 부족할 경우 시스템은 RAM을 사용하게 되며, 이는 GPU보다 속도가 느린 RAM의 특성상 연산 속도가 저하될 수 있습니다. 그럼에도 불구하고, 이 기능은 VRAM 부족으로 인해 발생하는 "Out of Memory" 오류를 방지하는 데 매우 유용합니다. 비록 속도 저하는 있을 수 있지만, 시스템 안정성을 확보하여 작업 중단을 예방할 수 있습니다.

ComfyUI 실행 명령어

# Windows PowerShell

python main.py --reserve-vram 1.0

위 명령어는 ComfyUI를 실행할 때 VRAM의 1.0GB를 항상 예약하여 남겨두겠다는 의미입니다. 이 설정을 통해 ComfyUI에서 이미지를 생성할 때, 1.0GB의 VRAM은 항상 여유로 남아 있게 됩니다. 이를 통해 ComfyUI를 실행하면서도 웹 서핑 같은 가벼운 작업을 병행할 수 있습니다.

추가적인 활용 팁:

- VRAM 예약 값을 1.0GB에서 상황에 맞게 조정할 수 있습니다. GPU 리소스가 더 부족하다면 이 값을 더 높여서 시스템 안정성을 확보할 수 있습니다.

- 만약 GPU의 성능이 충분하다면 예약 VRAM을 낮추거나 생략하여 최적의 성능을 얻을 수 있습니다.

- 또한, 메모리 절약을 위해 FP8 모델을 사용하는 것도 VRAM 관리에 도움이 됩니다. FP16에 비해 메모리 소모가 적어 VRAM 여유를 더 확보할 수 있습니다.

이 설정을 활용하면, VRAM이 제한적인 환경에서도 안정적인 이미지 생성 작업을 수행할 수 있습니다.

이 포스팅에서는 FLUX 모델을 ComfyUI를 통해 저사양 환경에서도 효율적으로 사용하는 방법에 대해 설명드렸습니다. FP8 버전의 FLUX 모델은 VRAM 소모를 줄이고 성능을 최적화하여 더 낮은 사양의 PC에서도 이미지 생성이 가능하도록 설계되었습니다. VRAM 예약 기능을 활용하여 안정적인 작업 환경을 유지하면서도, 웹 서핑과 같은 가벼운 작업을 병행할 수 있는 유용한 팁도 함께 소개했습니다.

비록 FP8 버전이 FP16에 비해 성능이나 이미지 품질에서 약간의 차이가 있을 수 있지만, 이를 거의 느끼지 못할 정도로 높은 퀄리티를 유지하며 빠른 속도로 이미지를 생성할 수 있다는 점이 큰 장점입니다. 특히, 제한된 하드웨어 자원을 최대한 활용하면서도 효율적인 작업을 원하는 사용자들에게 매우 적합한 선택이 될 것입니다.

이 포스팅에서 설명한 방법을 통해 FLUX 모델을 보다 쉽게 설치하고 실행할 수 있으며, 저사양 환경에서도 AI 이미지 생성의 강력한 성능을 체감하실 수 있습니다. 앞으로도 FLUX와 ComfyUI의 새로운 기능이나 업데이트된 정보를 바탕으로 추가적인 팁을 제공드리도록 하겠습니다. 계속해서 기대해 주세요. 😊