안녕하세요,

인공지능(AI)이 일상에 깊숙이 자리 잡고 있는 지금, LG가 국내 최초로 개발한 오픈소스 AI 모델 "EXAONE 3.0"이 주목받고 있습니다. 이 모델은 다양한 산업 분야에서 활용될 수 있을 만큼 강력한 성능을 자랑하며, 한국어와 영어 등 다양한 언어와 분야에서 뛰어난 성과를 보이고 있습니다. 복잡한 기술 용어 없이도 누구나 쉽게 접근할 수 있는 이 모델은 AI 기술의 새로운 가능성을 열어갈 중요한 도구가 될 것입니다.

1. EXAONE 3.0 이란?

"EXAONE 3.0"은 LG가 개발한 최첨단 AI 모델로, 기존 모델보다 56% 빠르고 비용은 72% 절감된 것이 특징입니다. 이 모델은 전력 소비를 최소화하면서도 높은 성능을 유지하도록 설계되었습니다. 한국어와 영어를 지원하며, 6천만 건 이상의 전문 데이터를 학습했습니다. 또한, "EXAONE 3.0"은 다양한 산업에 적용될 수 있는 높은 유연성을 갖추고 있으며, 의료, 금융, 제조업 등에서 활용될 예정입니다. LG는 이를 통해 AI 연구 생태계를 강화할 계획입니다. 자세한 내용은 LG Research 블로그에서 확인하실 수 있습니다.

LG Research 블로그 : https://www.lgresearch.ai/blog/view?seq=459

EXAONE 3.0 : 글로벌 Top 수준의 성능 갖춘 오픈소스 모델 공개 - LG AI Research BLOG

www.lgresearch.ai

2. 주요 특징

- 고성능과 효율성: 이전 모델보다 56% 빠르고, 72%의 비용 절감.

- 다국어 지원: 한국어와 영어를 지원. (특히 한국어 사용에 큰 효율을 보임)

- 방대한 데이터 학습: 6천만 건 이상의 전문 데이터를 학습, 향후 1억 건으로 확대 예정.

- 산업 적용 가능성: 의료, 금융, 제조업 등 다양한 산업에서 활용 가능.

- 오픈소스 공개: AI 연구 생태계 강화를 위해 오픈소스로 제공.

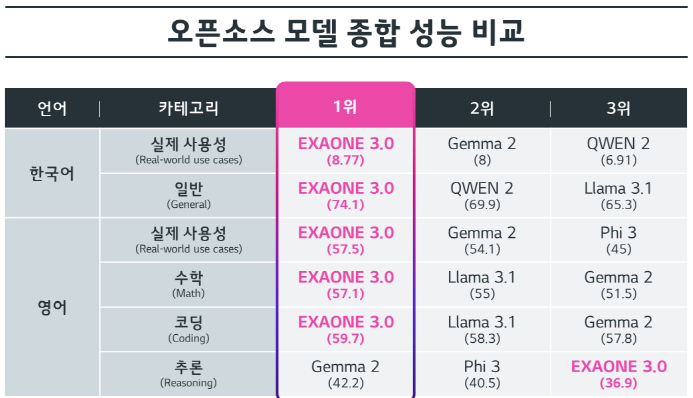

"EXAONE 3.0"은 LG AI연구원이 개발한 국내 최초의 오픈소스 AI 모델로, 한국어와 영어의 실제 사용성, 수학, 코딩 등 다양한 분야에서 뛰어난 성능을 보여줍니다. 주요 경쟁 모델들과 비교했을 때도 대부분의 카테고리에서 1위를 차지하며 우수한 효율성을 자랑합니다. 다만, 영어 추론 분야에서는 상대적으로 낮은 점수를 기록하여 개선의 여지가 있습니다. 이 모델은 7.8B 매개변수와 8T의 학습 데이터를 사용하여 최적화된 성능을 제공합니다.

현재 EXAONE 3.0 모델은 허깅페이스에서 오픈소스로 공개되어 있으며, 연구 목적으로 누구나 활용할 수 있습니다. 이제 이 모델을 로컬 환경에 설치하고 실행하는 과정에 대해 알아보겠습니다.

EXAONE 3.0 허깅페이스 : https://huggingface.co/LGAI-EXAONE/EXAONE-3.0-7.8B-Instruct

LGAI-EXAONE/EXAONE-3.0-7.8B-Instruct · Hugging Face

EXAONE-3.0-7.8B-Instruct 👋👋 We have revised our license for revitalizing the research ecosystem.👋👋 Introduction We introduce EXAONE-3.0-7.8B-Instruct, a pre-trained and instruction-tuned bilingual (English and Korean) generative model with 7.8

huggingface.co

3. 실행환경

- 운영체제: Windows 11 (64-bit)

- Python: 3.10.14

- torch: 2.3.1

- transformers: 4.44.0

- GPU: NVIDIA GeForce RTX 4060 Ti

4. EXAONE 3.0 설치

1) 소스파일 다운로드

EXAONE 3.0 모델은 LG AI 허깅페이스에서 다운받을 수 있습니다. 아래 URL을 통해 다운받으시면 됩니다.

- EXAONE 3.0 허깅페이스 : https://huggingface.co/LGAI-EXAONE/EXAONE-3.0-7.8B-Instruct

다운받으실 때 git을 통해 한번에 다운받으실 수 있습니다.

# Windows PowerShell

git clone https://huggingface.co/LGAI-EXAONE/EXAONE-3.0-7.8B-Instruct

만약 git을 따로 설치하지 않으신 분들은 해당 페이지에서 다운로드 버튼을 통해 직접 다운받으셔도 무방합니다.

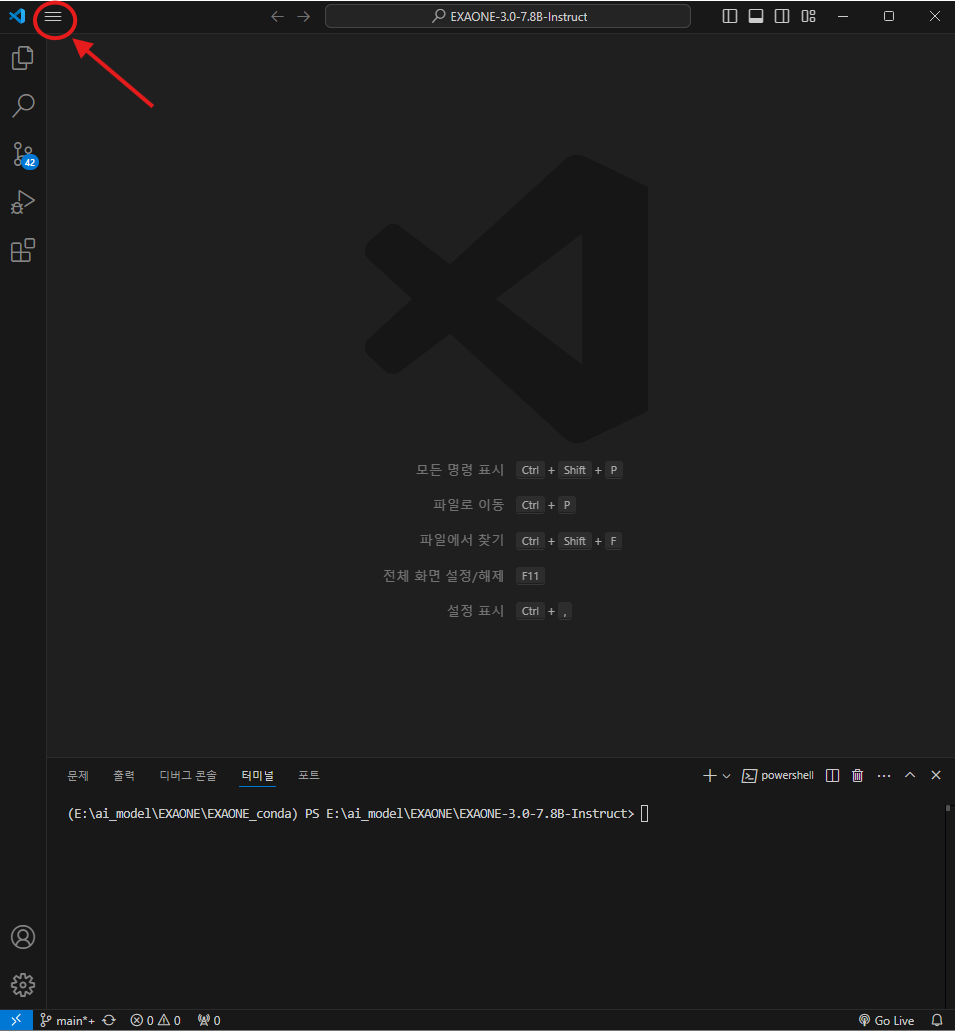

2) VS Code (Visual Studio Code)

VS Code 편집기를 통해 다운받은 "EXAONE-3.0-7.8B-Instruct 폴더"를 열어줍니다.

3) Torch & Transformers 패키지 설치

EXAONE 3.0 모델을 실행하기 위해 필요한 패키지들을 다운로드합니다. VS Code에서 터미널을 열고 아래 명령어를 실행하세요. 터미널이 닫혀 있다면, 단축키 (Ctrl + `)를 사용해 열 수 있습니다. 이 명령어를 통해 Torch와 Transformers 패키지가 모두 설치됩니다.

# VS Code의 터미널 창

pip install transformers[torch]

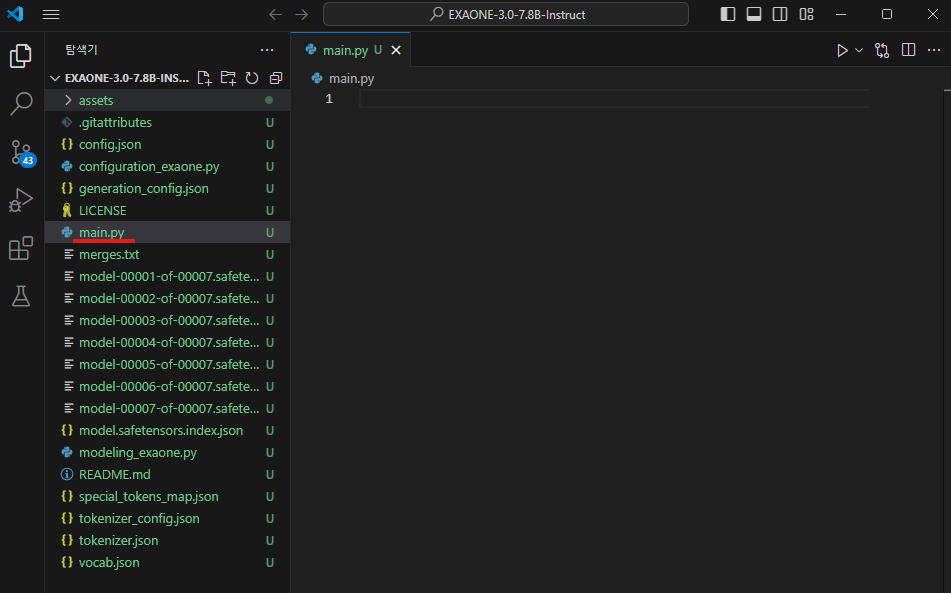

4) main.py 코드 작성

이제 모델을 실행할 Python 코드를 작성합니다. 새 파일 만들기 버튼을 클릭하고 "main.py"라는 이름으로 파일을 생성하세요. 파일 이름은 자유롭게 정할 수 있지만, 파일 확장자는 반드시 ".py"로 해야 Python 파일로 인식됩니다.

아래의 코드를 Python 파일에 넣어줍니다.

# Python

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

# 로컬 경로를 지정합니다.

model_path = "E:/ai_model/EXAONE/EXAONE-3.0-7.8B-Instruct"

tokenizer_path = "E:/ai_model/EXAONE/EXAONE-3.0-7.8B-Instruct"

# 로컬에서 모델과 토크나이저를 로드합니다.

model = AutoModelForCausalLM.from_pretrained(

model_path,

torch_dtype=torch.bfloat16,

trust_remote_code=True,

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained(tokenizer_path)

# 프롬프트 설정

prompt = "Explain who you are" # English example

prompt = "너의 소원을 말해봐" # Korean example

messages = [

{"role": "system",

"content": "You are EXAONE model from LG AI Research, a helpful assistant."},

{"role": "user", "content": prompt}

]

input_ids = tokenizer.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=True,

return_tensors="pt"

)

# 모델에 입력을 전달하여 결과 생성

output = model.generate(

input_ids.to("cuda"),

eos_token_id=tokenizer.eos_token_id,

max_new_tokens=128

)

# 출력 디코딩 및 출력

print(tokenizer.decode(output[0]))

위 코드를 'main.py'에 그대로 입력하시면 됩니다. 단, model과 tokenizer의 경로는 사용자의 EXAONE-3.0-7.8B-Instruct 폴더 위치에 맞게 반드시 수정해 주세요.

모두 작성하셨다면 준비가 완료되었습니다. 😊

5. EXAONE 3.0 실행

위에서 작성한 'main.py' 파일을 실행하면 아래와 같이 실행됩니다. 아래 터미널 창에서 실행 결과가 출력됩니다. 처음 실행하게 되면 해당 모델들을 로드하며 다소 시간이 소요됩니다.

[user]는 사용자가 질문을 한 내용이고, [assistant]가 바로 EXAONE 3.0 모델이 답변을 준 내용입니다.

EXAONE 3.0 모델을 직접 설치하고 실행해 보았습니다. LG AI Research에서 개발한 이 모델은 고도화된 자연어 처리 능력을 바탕으로 다양한 텍스트 생성 작업에서 탁월한 성능을 발휘합니다.

평소에 다루던 모델과 달리, EXAONE 3.0은 샤드 형태로 나뉜 가중치를 로드하여 실행해야 했기 때문에 생각보다 시간이 많이 소요되었습니다. 앞으로 더 연구하여 로컬 환경에서 모델을 보다 간편하게 실행할 수 있는 방법을 찾아보고, 알게 되는 대로 다시 공유해드리겠습니다.

앞으로도 AI와 관련된 다양한 주제를 탐구해 나갈 예정이니, 더 많은 정보를 원하시면 블로그를 계속해서 방문해 주세요. 이 글이 여러분에게 AI를 조금 더 친숙한 도구로 만들어 주었기를 바랍니다.

감사합니다!

'AI 소식 > 오픈소스 AI 모델' 카테고리의 다른 글

| [오픈 소스 AI] [로컬 환경] GPT-4o에 필적하는 메타의 새로운 AI 모델, Llama 3.1을 소개합니다. (7) | 2024.09.05 |

|---|---|

| [3D 모델 생성] [로컬 환경] 이미지를 3D 모델로 생성해주는 AI, Stable Fast 3D (SF3D)를 소개합니다. (2) | 2024.08.23 |

| [영상 생성 AI] [로컬 환경] 오픈 소스 ToonCrafter를 소개합니다. (0) | 2024.07.28 |

| [영상 생성 AI 모델] 소리에 맞게 입 모양을 만들어주는 AI, Hallo를 소개합니다. (0) | 2024.07.16 |

| [이미지 생성 AI] Stable Diffusion 로컬 환경에서 사용하기 (0) | 2024.06.14 |