안녕하세요

최근 많은 기업들이 소형언어모델(SLM)을 개발하여 오픈소스로 공개하고 있습니다. 이 모델들은 접근성이 뛰어나 개인 개발자나 소규모 팀도 쉽게 AI 기반 프로젝트를 시작할 수 있게 해줍니다. 이번 포스팅에서는 이러한 SLM을 로컬 환경에서 구현하는 방법을 단계별로 설명하려고 합니다.

1. EEVE 모델이란

EEVE 모델은 야놀자에서 공개한 오픈소스 AI 모델로, upstage의 LLM Solar 모델을 한국어 어휘로 확장하여 미세 조정한 버전입니다. Solar 모델은 영어와 한국어를 모두 지원하는 경량이면서도 강력한 모델로, 다중 턴 채팅과 같은 복잡한 자연어 처리 작업에서 향상된 성능을 제공합니다. EEVE 모델은 한국어 사용자의 요구에 더욱 잘 부응하도록 조정된 AI 모델입니다.

2. 설치 계획

오픈소스로 공개된 LLM 모델을 활용하기 위해 몇 가지 추가적인 단계가 필요합니다. 이번 포스팅에서는 Ollama를 사용하여 LLM 모델을 실행하는 방법을 소개할 예정입니다. 설치 계획은 다음과 같이 진행됩니다.

- Ollama 설치

- EEVE GGUF 파일 다운로드

- Ollama를 이용하여 EEVE 모델 생성 및 실행

로컬 환경에 Ollama를 설치하는 것이 첫 번째 단계입니다. 단순히 오픈소스 LLM 모델을 다운로드하는 것만으로는 즉시 사용할 수 없기 때문에, 이를 설치하고 실행할 수 있게 해주는 AI 도구인 Ollama를 활용해야 합니다. Ollama에 대해 더 자세히 알고 싶으시다면, 아래 링크에서 이전에 작성된 포스팅을 확인하시면 많은 도움이 될 것입니다.

[Marcus' Stroy] 로컬 언어 모델의 시작, Ollama를 소개합니다.

다음으로는 EEVE 모델의 GGUF 파일을 다운로드합니다. GGUF 파일은 대형 언어 모델(LLM)을 저장하고 처리하기 위해 특별히 설계된 이진 파일 형식으로, GGML 라이브러리와 호환됩니다. 이 라이브러리는 대형 모델을 효과적으로 실행할 수 있도록 개발되었으며, GGUF 파일 형식은 모델 데이터를 저장하고 빠르게 로드할 수 있도록 합니다. 이 파일을 로컬 환경에 다운로드하여 사용 준비를 합니다.

마지막으로, 다운로드한 EEVE GGUF 파일을 Ollama를 사용하여 로컬 환경에서 설치하고 실행합니다. Ollama는 EEVE GGUF 파일을 읽어 직접적으로 활용 가능한 LLM 모델로 변환합니다. 이 단계를 완료하면, 로컬 환경에서 우리가 만든 LLM 모델을 ChatGPT와 같이 질의응답 형태로 사용할 수 있게 됩니다.

3. 실행 환경

- 운영체제 Window11

- Ollama Version 0.1.34

4. 설치

여기에는 오픈소스 LLM 모델인 EEVE를 로컬 환경에서 활용하기 위해 필요한 과정을 단계별로 설명하겠습니다.

1) Ollama 설치

- Ollama는 로컬 컴퓨터에서 LLM 모델을 설정하고 실행할 수 있는 도구입니다. 설치 파일은 Ollama 공식 웹사이트에서 다운로드할 수 있습니다.

- Ollama 다운로드페이지 - https://ollama.com/download

2) EEVE GGUF 파일 다운 받기

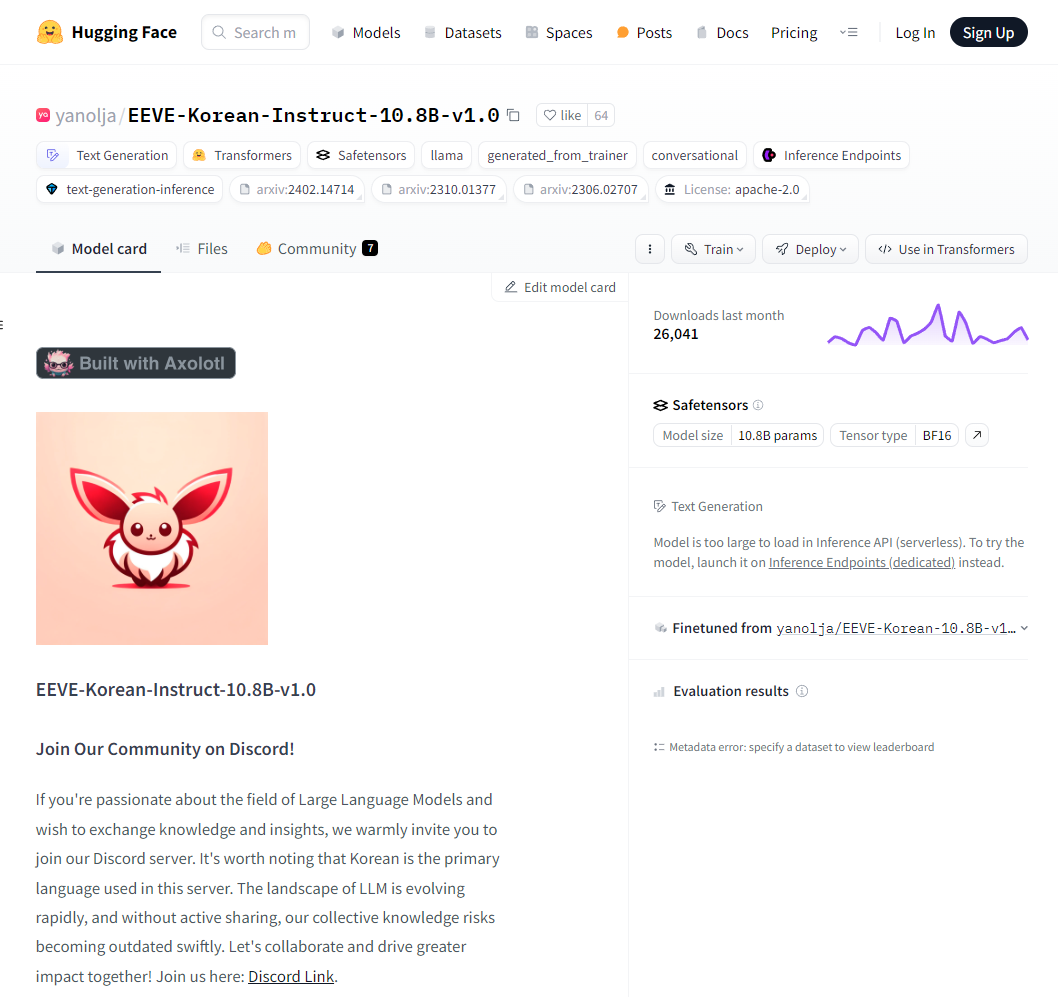

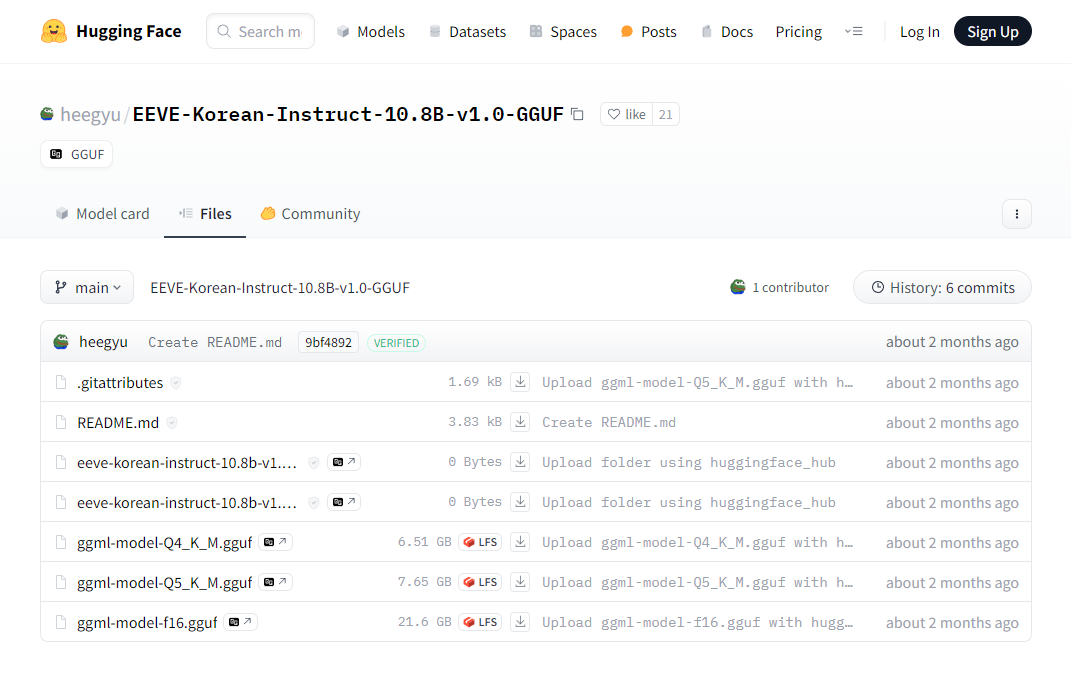

- EEVE 모델은 야놀자가 공개한 한국어 확장 버전의 LLM입니다. 해당 모델의 GGUF 파일은 허깅페이스에서 다음 링크를 통해 다운로드 가능합니다.

- EEVE 모델 GGUF 파일 다운로드 - https://huggingface.co/heegyu/EEVE-Korean-Instruct-10.8B-v1.0-GGUF

야놀자에서 공개한 EEVE 모델에 대한 정보는 아래 야놀자 허깅페이스에서 확인하실 수 있습니다. 하지만 해당 페이지에서 GGUF 파일이 없어 다른 페이지(허깅페이스 username : heegyu)에서 업로드된 GGUF파일을 사용하겠습니다.

- 야놀자 허깅페이스 - https://huggingface.co/yanolja/EEVE-Korean-Instruct-10.8B-v1.0

- heegyu 허깅페이스 - https://huggingface.co/heegyu/EEVE-Korean-Instruct-10.8B-v1.0-GGUF (EEVE모델 GGUF 파일 다운 URL과 동일)

3) Ollama를 이용하여 EEVE 모델 생성 및 실행

a) Ollama에서 모델을 생성하고 실행하기 위해 Modelfile을 준비합니다. 이 파일은 Ollama에서 사용할 수 있는 모델의 설정과 명령을 정의합니다. 모델 파일 작성 방법은 Ollama 문서에서 자세한 정보를 제공합니다.

- Ollama Model File 자료 - https://github.com/ollama/ollama/blob/main/docs/modelfile.md

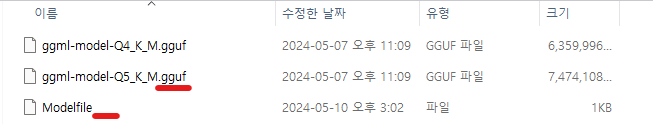

b) 모델 파일은 간단한 텍스트 에디터로 작성할 수 있으며, 파일 확장명을 삭제하여 'Modelfile'로 저장합니다.

텍스트 문서(메모장) 만들기 -> Modelfile 내용 작성 -> 저장 -> 이름변경 (Modelfile로 수정 및 확장명 삭제 후 저장)

확장명을 삭제했다면 아래 사진과 같이 파일명이 나타나야합니다.

Modelfile 내용은 ollama 문법과 야놀자 허깅페이스 내용을 참고하여 작성하였습니다. 아래 내용은 제가 만든 Modelfile의 예시입니다.

FROM ggml-model-Q5_K_M.gguf

TEMPLATE """{{ if .System }}

<|start_header_id|>{{ .System }}<|end_header_id|>

{{ end }}

<|start_header_id|>Human:

{{ .Prompt }}<|end_header_id|>

<s>Assistant:

"""

SYSTEM """

A chat between a curious user and an artificial intelligence assistant. The assistant gives helpful, detailed, and polite answers to the user's questions.

"""

PARAMETER stop "<|start_header_id|>"

PARAMETER stop "<|end_header_id|>"

PARAMETER stop "<|eot_id|>"

PARAMETER stop "<|reserved_special_token"

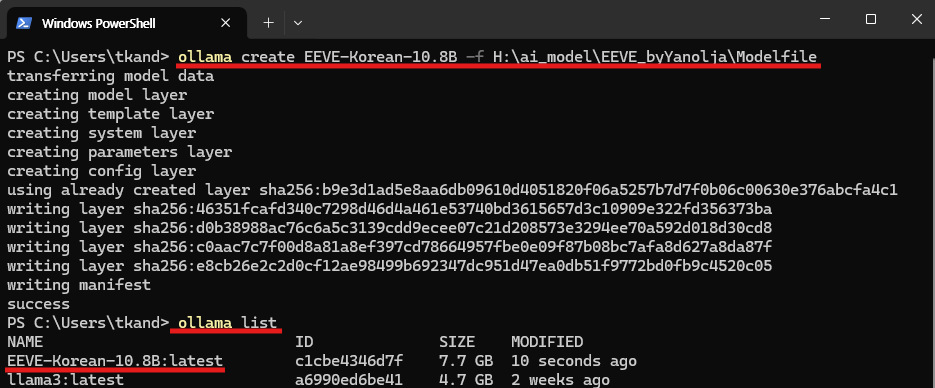

c) Windows PowerShell 실행 - 작업표시줄 검색창에서 "Windows PowerShell" 입력 -> 실행

d) EEVE모델 생성 및 확인

Windows PowerShell에서 아래의 명령어를 통해 모델생성 및 확인

- 모델 생성 : ollama create [모델명] -f [경로/Modelfile] (※ 모델명과경로는 사용자 환경에 맞게 수정)

- 리스트 확인 : ollama list

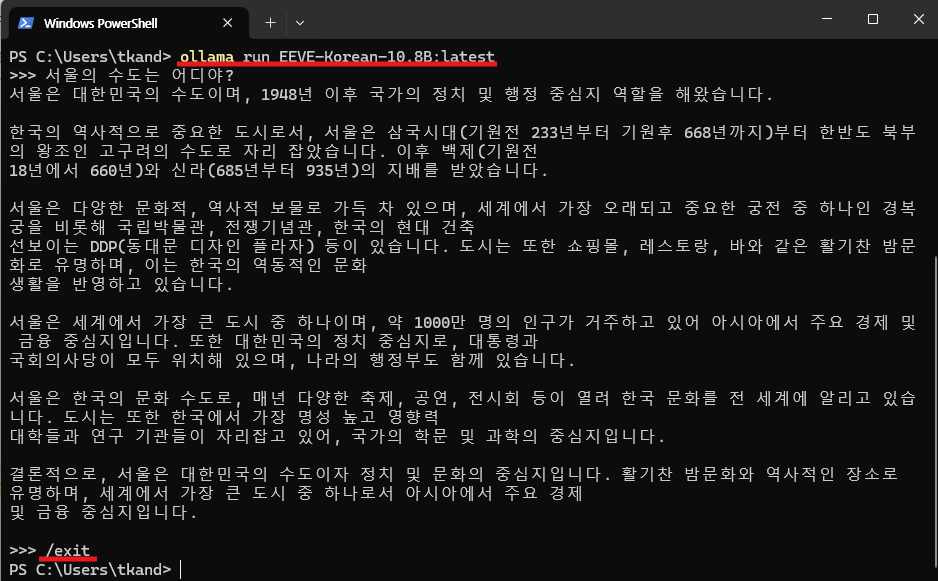

5. 설치한 모델 실행

EEVE모델 실행 : ollama run [EEVE모델명] (※ 모델명은 사용자 환경에 맞게 수정)

요즘 소형언어모델(SLM)들이 계속해서 쏟아져 나오고 있습니다. 그에 따라 오픈소스로 제공된 SLM을 로컬 환경에서 구현하는 방법에 대해 포스팅해 보았습니다. 다음 글에서는 LangServe를 사용하여 로컬에서 구현한 AI 모델을 다른 사람들도 이용할 수 있도록 배포하는 방법을 소개하고, RAG(Retrieval-Augmented Generation) 기술을 통해 모델이 최신 정보도 활용할 수 있게 하는 방법에 대해 알아보겠습니다.

감사합니다 :)

출처

1) 야놀자 허깅페이스 - https://huggingface.co/yanolja/EEVE-Korean-Instruct-10.8B-v1.0

2) heegyu 허깅페이스 - https://huggingface.co/heegyu/EEVE-Korean-Instruct-10.8B-v1.0-GGUF

3) ollama 공식깃허브 페이지 - https://github.com/ollama/ollama

'AI 소식 > 오픈소스 AI 모델' 카테고리의 다른 글

| 오픈소스 EEVE 모델 로컬환경에서 실행하기 3탄 (RemoteRunnable / Streamlit) (0) | 2024.05.28 |

|---|---|

| 오픈소스 EEVE 모델 로컬환경에서 실행하기 2탄 (LangChain / LangServe / ngrok) (0) | 2024.05.17 |

| 로컬 언어 모델의 시작, Ollama를 소개합니다. (0) | 2024.04.25 |

| 구글 AI모델, Gemma 사용하기 1탄 (0) | 2024.03.16 |

| Google의 AI모델, Gemma (0) | 2024.03.05 |